diff --git a/.gitignore b/.gitignore

old mode 100755

new mode 100644

diff --git a/1.Java Based.md b/1.Java Based.md

old mode 100755

new mode 100644

index b1d7ce6..c224e3c

--- a/1.Java Based.md

+++ b/1.Java Based.md

@@ -27,36 +27,29 @@ JDK8后,接口中可以包含default方法,抽象类中不可以

### 面向对象开发的六个基本原则,在项目中用过哪些原则

- 六个基本原则

-

- - 单一原则

-

- 一个类只做它该做的事情(高内聚)。在面向对象中,如果只让一个类完成它该做的事,而不涉及与它无关的领域就是践行了高内聚的原则,这个类就只有单一原则

-

- - 开闭原则

-

- 软件实体应当对扩展开发,对修改关闭,要做到开闭有两个要点:

-

- 1. 抽象是关键,一个系统中如果没有抽象类或接口系统就没有扩展点

- 2. 封装可变性,将系统中的各种可变因素封装到一个继承结构中,如果多个可变因素混杂在一起,系统将变的复杂而繁乱

-

- - 里氏替换原则

-

- 任何时候都可以用子类型替换掉父类型,子类一定是增加父类的能力而不是减少父类的能力

-

- - 依赖倒置原则

-

- 面向接口编程。高层模块不应该依赖底层模块,两者都应该依赖其抽象,尽可能使用抽象类型而不用具体类型,因为抽象类型可以被它的任何一个子类型所替代。

-

- - 接口隔离原则

-

- 类间的依赖关系应该建立在最小的接口上,不能大而全,接口表示能力,一个接口只应该描述一种能力,接口也应该高度内聚

-

- - 迪米特法则

-

- 由叫最少知识原则,一个对象应该对其他对象有尽可能少的了解

+

+ - 单一原则

+ 一个类只做它该做的事情(高内聚)。在面向对象中,如果只让一个类完成它该做的事,而不涉及与它无关的领域就是践行了高内聚的原则,这个类就只有单一原则

+

+ - 开闭原则

+ 软件实体应当对扩展开发,对修改关闭,要做到开闭有两个要点:

+

+ 1. 抽象是关键,一个系统中如果没有抽象类或接口系统就没有扩展点

+ 2. 封装可变性,将系统中的各种可变因素封装到一个继承结构中,如果多个可变因素混杂在一起,系统将变的复杂而繁乱

+

+ - 里氏替换原则

+ 任何时候都可以用子类型替换掉父类型,子类一定是增加父类的能力而不是减少父类的能力

+

+ - 依赖倒置原则

+ 面向接口编程。高层模块不应该依赖底层模块,两者都应该依赖其抽象,尽可能使用抽象类型而不用具体类型,因为抽象类型可以被它的任何一个子类型所替代。

+

+ - 接口隔离原则

+ 类间的依赖关系应该建立在最小的接口上,不能大而全,接口表示能力,一个接口只应该描述一种能力,接口也应该高度内聚

+

+ - 迪米特法则

+ 又叫最少知识原则,一个对象应该对其他对象有尽可能少的了解

- 根据自己的项目来说

-

详细的可以看这里:https://www.cnblogs.com/qifengshi/p/5709594.html

> 关于网络方面的问题,面试官应该只会问一题,不会多问

@@ -73,37 +66,47 @@ JDK8后,接口中可以包含default方法,抽象类中不可以

### TCP 三次握手,四次挥手

-可见该文:https://blog.csdn.net/qq_38950316/article/details/81087809

+* **SYN(Synchronize)**:同步标志位,用于发起连接、请求同步序列号。

+* **ACK(Acknowledgment)**:确认标志位,用于确认收到对方数据,`ACK=1`表示确认有效。

+* **序列号(Seq)**:随机生成的初始值(ISN,Initial Sequence Number),后续数据按 "Seq + 数据长度" 递增,确保数据有序。

+* **确认号(Ack)**:表示 "期望收到对方的下一个序列号",值为 "对方已发 Seq + 已接收数据长度"。

+- 三次握手详细流程(以 "客户端→服务器" 建立连接为例)

+

+| 步骤 | 发起方 | 标志位 | 关键字段 | 目的 |

+| --- | --- | ---------------- | ------------------------------ | --------------------------------------------------------------------------------------------------------- |

+| 1 | 客户端 | SYN=1 | Seq = x(随机初始值) | 向服务器 "请求建立连接",并告知服务器:"我后续发送数据的序列号从 x 开始"。 |

+| 2 | 服务器 | SYN=1

ACK=1 | Seq = y(服务器随机值)

Ack = x+1 | 1. 用`ACK=1`和`Ack=x+1`确认 "已收到客户端的连接请求";

2. 用`SYN=1`和`Seq=y`向客户端发起 "反向连接请求",告知客户端:"我后续发送数据的序列号从 y 开始"。 |

+| 3 | 客户端 | ACK=1 | Seq = x+1

Ack = y+1 | 用`ACK=1`和`Ack=y+1`确认 "已收到服务器的反向连接请求",至此双方确认 "收发能力正常",连接建立。 |

+

+- 四次挥手详细流程(以 "客户端→服务器" 主动断开连接为例)

+

+| 步骤 | 发起方 | 标志位 | 关键字段 | 目的 |

+| --- | --- | ---------------- | ------------------------------------------ | -------------------------------------------------------------------------------------------------------------------------- |

+| 1 | 客户端 | FIN=1

ACK=1 | Seq = u(客户端当前 Seq)

Ack = v(服务器当前 Ack) | 客户端告知服务器:"我没有数据要发了,请求关闭我的发送通道(单向)",但仍能接收服务器的数据。 |

+| 2 | 服务器 | ACK=1 | Seq = v

Ack = u+1 | 服务器确认 "已收到客户端关闭发送通道的请求",此时客户端→服务器的发送通道关闭,但服务器→客户端的发送通道仍可传输数据(服务器可能还有未发完的数据)。 |

+| 3 | 服务器 | FIN=1

ACK=1 | Seq = w(服务器剩余数据后的 Seq)

Ack = u+1 | 服务器发送完所有剩余数据后,告知客户端:"我也没有数据要发了,请求关闭我的发送通道(单向)"。 |

+| 4 | 客户端 | ACK=1 | Seq = u+1

Ack = w+1 | 客户端确认 "已收到服务器关闭发送通道的请求",此时服务器→客户端的发送通道关闭。客户端会等待**2MSL(Maximum Segment Lifetime,报文最大生存时间)** 后释放连接(确保服务器能收到该确认,避免服务器重发 FIN)。 |

### TCP 和 UDP区别

- 区别:

-

UDP是无连接的,即发送数据之前不需要建立连接

-

UDP使用尽最大努力交付,即不保证可靠交付,同时也不使用拥塞控制

-

UDP是面向报文的,没有拥塞控制,适合多媒体通信要求

-

UDP支持一对一,一对多,多对一和多对多的交互通信

-

UDP首部开销小,只有8个字节

-

TCP是面向连接的运输层协议

-

TCP只能一对一连接

-

TCP提供可靠的交付服务,提供全双工通信

-

TCP 面向字节流,头部最低20个字节

### 从输入网址到获取页面的过程

- 查询DNS, 获取域名对应的IP地址

- - 浏览器搜索自身的DNS缓存

- - 搜索操作系统的DNS缓存

- - 读取本地的HOST文件

- - 发起一个DNS系统调用(宽带运营服务器查看本身缓存,运营服务器发起一个迭代DNS解析请求)

+ - 浏览器搜索自身的DNS缓存

+ - 搜索操作系统的DNS缓存

+ - 读取本地的HOST文件

+ - 发起一个DNS系统调用(宽带运营服务器查看本身缓存,运营服务器发起一个迭代DNS解析请求)

- 浏览器获得域名对应的IP地址后,发起HTTP三次握手

- TCP/IP建立连接后,浏览器可以向服务器发送HTTP请求了

- 服务器接收到请求后,根据路径参数,经过后端处理将页面返回给浏览器

@@ -117,28 +120,24 @@ Session:

Cookie:

-数据已文件形式存在用户浏览器端,用户可以通过浏览器禁用Cookie,用户可以对Cookie进行查看,修改,和删除

+数据以文件形式存在用户浏览器端,用户可以通过浏览器禁用Cookie,用户可以对Cookie进行查看,修改,和删除

### 列出自己常用的JDK包

常用的包:

-java.lang 包装类,线程等都在该包

+java.lang 包装类,线程等都在该包

-java.match 有BigDecimal 精确数字类型

+java.math 有BigDecimal 精确数字类型

java.util 并发,集合等都在该包内

### equals与==的区别

1. equals 比较两个实体值是否相同,可以被覆盖,但需要遵循几个约定:

-

自反性:对于任何非null的引用值x, x.equals(x)必须返回true

-

对称性:对于任何非null的引用值x和y,当y.equals(x)返回true时,x.equlas(y)必须返回true

-

传递性:对于任何非null的引用值x、y、z,如果x.equals(y)返回true,并且y.equals(x)也返回true,那么x.equals(z)也必须返回true

-

一致性:对于任何非null的引用值x和y,只要比较对象中的所有信息没有被修改,多次调用equals一致返回true,或者false

2. == 比较两个实体的引用地址是否相等,不能覆盖,如果引用地址相等,那认为两个实体为同一个实体

@@ -217,9 +216,92 @@ wait(long timeout)导致当前的线程等待,直到其他线程调用此对

### 创建线程的方式

-1. 继承Thread类创建线程,并重写run方法,调用实例对象的start()方法启动线程

-2. 实现Runnable接口,并实现run方法,将实现Runnable的类传入Thread构造函数中,并调用Thread实例对象的start方法启动线程

-3. 实现Callable接口,并实现call方法,创建Callable实现类的实例,使用FutureTask包装Callable对象,使用FutureTask对象传入Thread中,调用start方法启动线程,使用FutureTask对象的get方法获取线程的返回值

+- 继承Thread类创建线程,并重写run方法,调用实例对象的start()方法启动线程

+

+```java

+public class ThreadDemo extends Thread {

+ @Override

+ public void run() {

+ // 线程执行逻辑

+ for (int i = 0; i < 5; i++) { + System.out.println(Thread.currentThread().getName() + ": " + i); + } + } + + public static void main(String[] args) { + ThreadDemo thread = new ThreadDemo(); + thread.setName("子线程1"); + thread.start(); // 启动线程,JVM会调用run() + + // 主线程逻辑 + for (int i = 0; i < 5; i++) { + System.out.println(Thread.currentThread().getName() + ": " + i); + } + } +} +``` + +- 实现Runnable接口,并实现run方法,将实现Runnable的类传入Thread构造函数中,并调用Thread实例对象的start方法启动线程 + +```java +public class RunnableDemo implements Runnable { + @Override + public void run() { + // 线程执行逻辑 + for (int i = 0; i < 5; i++) { + System.out.println(Thread.currentThread().getName() + ": " + i); + } + } + + public static void main(String[] args) { + // 创建任务对象 + RunnableDemo task = new RunnableDemo(); + + // 创建线程并关联任务 + Thread thread = new Thread(task, "子线程1"); + thread.start(); + + // 主线程逻辑 + for (int i = 0; i < 5; i++) { + System.out.println(Thread.currentThread().getName() + ": " + i); + } + } +} +``` + +- 实现Callable接口,并实现call方法,创建Callable实现类的实例,使用FutureTask包装Callable对象,使用FutureTask对象传入Thread中,调用start方法启动线程,使用FutureTask对象的get方法获取线程的返回值 + +```java +import java.util.concurrent.Callable; +import java.util.concurrent.ExecutionException; +import java.util.concurrent.FutureTask; + +public class CallableDemo implements Callable {

+ @Override

+ public Integer call() throws Exception {

+ // 线程执行逻辑,返回计算结果

+ int sum = 0;

+ for (int i = 1; i <= 10; i++) { + sum += i; + } + return sum; + } + + public static void main(String[] args) throws ExecutionException, InterruptedException { + // 创建任务对象 + CallableDemo task = new CallableDemo(); + + // 包装任务,用于获取结果 + FutureTask futureTask = new FutureTask(task);

+

+ // 启动线程

+ new Thread(futureTask, "计算线程").start();

+

+ // 获取结果(会阻塞,直到子线程执行完毕)

+ System.out.println("1-10的和为:" + futureTask.get());

+ }

+}

+```

### ArrayList 与 LinkedList 区别

@@ -230,67 +312,50 @@ LinkedList是一种链式存储的线性表,本质是一个双向链表,实

### 自定义注解

1. 声明注解的保留期限类型

-

@Retention(RetentionPolicy.RUNTIME)表示该注解可以在运行期保留

-

保留期限类型:java.lang.annotation.Retention

-

SOURCE: 注解信息仅保留在目标类源代码文件中,对应的字节码文件不会保留

-

CLASS: 注解信息存在于源代码、字节码文件中,但运行期JVM不能获得该注解信息

-

RUNTIME: 注解信息存在于源代码、字节码文件、运行期JVM中,能够通过反射机制获取注解类信息

2. 声明注解可以使用的目标类型

-

@Target(ElementType.METHOD) 表示这个注解只能在方法上使用

-

目标类型:java.lang.annotation.ElementType

-

TYPE: 类、接口、注解类、Enum

-

FIELD: 类成员变量或常量

-

METHOD: 方法

-

PARAMETER: 参数

-

CONSTRUCTOR: 构造器

-

LOCAL_VARIABLE: 局部变量

-

ANNOTATION_TYPE: 注解

-

PACKAGE: 包

3. 使用@interface 修饰类

4. 声明注解成员

-

成员无入参、不能抛出异常;

-

可以通过default成员指定默认值

-

成员类型只能使用基本数据类型、String、Class、enums、注解类型,及上述类型的数组类型。如ForumService value()是非法的

-

如果注解只有一个成员,则成员名必须取名为value(),再使用时可以忽略成员名和赋值号,如果注解类拥有多个成员时,

-

对value成员赋值,可以省略value和赋值号,如果是多个成员赋值,必须使用赋值号

### ArrayList扩容机制是怎么样的? 详细说一下。

在往ArrayList add元素的时候,如果ArrayList 已有元素数量+1 大于 ArrayList 存储元素的总长度,就会触发扩容。

-首先ArrayList会计算新数组的长度,长度为老数组的0.5倍,如果新数组长度还是小于插入元素需要的最小长度,那么新数组长度赋值为最小长度,如果超过ArrayList允许的最大长度Integer.MAX_VALUE(2ドル^{31} - 1$),那么新数组长度为Integer.MAX_VALUE,否则为Integer.MAX_VALUE - 8(为什么要-8?[Why the maximum array size of ArrayList is Integer.MAX_VALUE - 8?](https://stackoverflow.com/questions/35756277/why-the-maximum-array-size-of-arraylist-is-integer-max-value-8))

+首先ArrayList会计算新数组的长度,长度为老数组的1.5倍,如果新数组长度还是小于插入元素需要的最小长度,那么新数组长度赋值为最小长度,如果超过ArrayList允许的最大长度Integer.MAX_VALUE(2ドル^{31} - 1$),那么新数组长度为Integer.MAX_VALUE,否则为Integer.MAX_VALUE - 8(为什么要-8?[Why the maximum array size of ArrayList is Integer.MAX_VALUE - 8?](https://stackoverflow.com/questions/35756277/why-the-maximum-array-size-of-arraylist-is-integer-max-value-8))

最后将原数组元素拷贝到新数组进行扩容

+> 为什么要预留8个字节

+>

+> 数组除了存储元素的数组体外,还需要额外的元数据来记录数组的长度、类型信息等,本质是 **为数组元数据预留内存空间**,避免因数组容量达到理论最大值时,元数据无内存可用而导致的分配失败

+

### HashMap 1.7 和 1.8 的区别

- 1.7,在发生hash冲突的时候,数据结构只有链表;

- 1.8,数据结构有链表和红黑树,使用红黑树是为了能够提高查询效率。在链表长度达到7时(bingCount>= TREEIFY_THRESHOLD - 1),并且hash tab[]数组长度大于等于64时,将链表转换成红黑树,如果数组长度小于64,只是对数组进行扩容

-

https://blog.csdn.net/qq_21251983/article/details/90056067

### HashMap中的key可以是任何对象或数据类型吗

@@ -326,16 +391,16 @@ cap -1 ,-1是为了在计算的时候能得到大于等于输入参数的值

```java

final Node[] resize() {

- //原table数组赋值

+ //原table数组赋值

Node[] oldTab = table;

- //如果原数组为null,那么原数组长度为0

+ //如果原数组为null,那么原数组长度为0

int oldCap = (oldTab == null) ? 0 : oldTab.length;

- //赋值阈值

+ //赋值阈值

int oldThr = threshold;

- //newCap 新数组长度

- //newThr 下次扩容的阈值

+ //newCap 新数组长度

+ //newThr 下次扩容的阈值

int newCap, newThr = 0;

- // 1. 如果原数组长度大于0

+ // 1. 如果原数组长度大于0

if (oldCap> 0) {

//如果大于最大长度1 << 30 = 1073741824,那么阈值赋值为Integer.MAX_VALUE后直接返回 if (oldCap>= MAXIMUM_CAPACITY) {

@@ -347,7 +412,7 @@ final Node[] resize() {

oldCap>= DEFAULT_INITIAL_CAPACITY)

newThr = oldThr << 1; // double threshold } - // 3. 如果原数组长度等于0,但原阈值大于0,那么新的数组长度赋值为原阈值大小 + // 3. 如果原数组长度等于0,但原阈值大于0,那么新的数组长度赋值为原阈值大小 else if (oldThr> 0) // initial capacity was placed in threshold

newCap = oldThr;

else { // zero initial threshold signifies using defaults

@@ -355,7 +420,7 @@ final Node[] resize() {

newCap = DEFAULT_INITIAL_CAPACITY;

newThr = (int)(DEFAULT_LOAD_FACTOR * DEFAULT_INITIAL_CAPACITY);

}

- // 5.如果新的阈值等于0

+ // 5.如果新的阈值等于0

if (newThr == 0) {

//计算临时阈值

float ft = (float)newCap * loadFactor;

@@ -363,13 +428,13 @@ final Node[] resize() {

newThr = (newCap < MAXIMUM_CAPACITY && ft < (float)MAXIMUM_CAPACITY ? (int)ft : Integer.MAX_VALUE); } - //计算出来的新阈值赋值给对象的阈值 + //计算出来的新阈值赋值给对象的阈值 threshold = newThr; @SuppressWarnings({"rawtypes","unchecked"}) - //用新计算的数组长度新建一个Node数组,并赋值给对象的table + //用新计算的数组长度新建一个Node数组,并赋值给对象的table Node[] newTab = (Node[])new Node[newCap];

table = newTab;

- //后面是copy数组和链表数据逻辑

+ //后面是copy数组和链表数据逻辑

if (oldTab != null) {

for (int j = 0; j < oldCap; ++j) { Node e;

@@ -467,13 +532,12 @@ if ((tab = table) == null || (n = tab.length) == 0)

- HashMap并发下产生问题:由于在发生hash冲突,插入链表的时候,多线程会造成环链,再get的时候变成死循环,Map.size()不准确,数据丢失

https://www.iteye.com/blog/hwl-sz-1897468

-

+

- HashTable: 通过synchronized来修饰,效率低,多线程put的时候,只能有一个线程成功,其他线程都处于阻塞状态

- ConcurrentHashMap:

1.7 采用锁分段技术提高并发访问率

1.8 数据依旧是分段存储,但锁采用了synchronized,内部采用Node数组+链表+红黑树的结构存储,当单个链表存储数量达到红黑树阈值8时(此时链表已有元素7),并且数组长度大于64时,存储结构转换为红黑树来存储,否则只进行数组的扩容

-

https://www.cnblogs.com/banjinbaijiu/p/9147434.html

### HashMap 为什么不用平衡树,而用红黑树

@@ -485,7 +549,7 @@ if ((tab = table) == null || (n = tab.length) == 0)

查找时间复杂度都维持在O(logN)

> 关于HashMap的其他文章:https://blog.csdn.net/login_sonata/article/details/76598675

->

+>

> 源码解析:https://www.jianshu.com/p/0a70ce2d3b67

### 常见异常分为哪两种(Exception,Error),区别是什么,了解受检异常和非受检异常吗

@@ -496,7 +560,7 @@ Error: 表示程序发生错误,是程序无法处理的,不可恢复的,

Exception: 表示程序可处理的异常,又分为CheckedException(受检异常)、UncheckedException(非受检异常),受检异常发生在编译期,必须要使用try...catch 或者 throws捕获或者抛出异常,否则编译不通过;非受检异常发生在运行期,具有不确定性,主要由程序的逻辑问题引起的,在程序设计的时候要认真考虑,尽量处理异常

-### 实现一个LRU

+### 实现一个LRU(最近最少使用)

可以直接使用LinkedHashMap实现

@@ -521,30 +585,25 @@ public class LRUCache extends LinkedHashMap {

}

```

-### 用过流没有,流怎么实现

-

-Stream流是Java8中引入的新特性,Stream有几个特点:

-

-不存数据,都是通过管道将源数据元素传递给操作;

-

-对Stream的任何修改都不会修改数据源,都是新产生一个流

-

-流的很多操作如filter、map都是延迟执行的,只有到终点才会将操作顺序执行

-

-对于无限流可以通过"短路"操作访问到有限元素后就返回

+### 获取一个Class对象的方式

-流的元素只访问一次,如果需要重新访问,需要重新生成一个新的流

+1. 通过类对象的getClass方法

-Stream中BaseStream规定了流的基本接口,在Stream中使用Stage来描述一个完整的操作,将具有先后顺序的各个Stage连一起,就构成了整个流水线。

+```java

+User user = new User();

+Class clazz = user.getClass();

+```

-AbstractPipeline是流水线的核心,定义了三个AbstractPipeline类型的变量:sourceStage(源阶段)、previousStage(上游pipeline,上一阶段),nexStage(下一阶段)

+2. 通过类的静态成员,每个类都有隐含的静态成员class

-ReferencePipeline 继承了AbstractPipeline

+```java

+Class clazz = User.class;

+```

-Head、StatefulOp、StatelessOp继承了ReferencePipeline,分别表示源,无状态操作,有状态操作

+3. 通过Class类的静态方法forName方法获取

-

+```java

+Class clazz = Class.forName("com.itsaysay.User");

+```

-比如Collection.stream()方法得到Head也就是stage0,紧接着调用一系列的中间操作,不断产生新的stage。这些stage对象以双向链表的形式组织在一起,构成整个流水线。

-由于每个Stage都记录了前一个Stage和本次的操作以及回调函数,依靠这种结构就建立起对数据源的所有操作。

diff --git a/10.Spring.md b/10.Spring.md

old mode 100755

new mode 100644

index 5aece9f..c3c7878

--- a/10.Spring.md

+++ b/10.Spring.md

@@ -6,17 +6,17 @@

### BeanFactory 与ApplicationContext 是干什么的,两者的区别

-BeanFactory、ApplicationContext都代表容器,BeanFactory是一个基础接口,实现了容器基础的功能,ApplicationContext是容器的高级形态,增加了许多了特性,顶级父类是BeanFactory。

+BeanFactory、ApplicationContext都代表容器,BeanFactory是一个基础接口,实现了容器基础的功能,ApplicationContext是容器的高级形态,增加了许多特性,顶级父类是BeanFactory。

跟FactoryBean的区别是:

-FactoryBean 是一个Bean,用于生产修饰其他的Bean实例,典型应用是AOP代理类,使用'&'获取FactoryBean本身

+FactoryBean 是一个Bean,用于创建或修饰其他的Bean实例,典型应用是AOP代理类,使用'&'获取FactoryBean本身,通过getObject来获取原来的Bean实例

-BeanFactory 是一个工厂,是容器的顶层接口

+BeanFactory 是一个工厂,是容器的顶层接口

### BeanPostProcessor 的实现

-Bean的后置处理器,是一个监听器,可以监听容器触发的事件。将它向IOC容器注册后,容器中管理的Bean具备了接收IOC容器事件回调的能力。BeanPostProcessor是一个接口类,有两个接口方法,postProcessBeforeInitialization提供Bean初始化前的回调入口;postProcessAfterInitialization 提供Bean初始化后的回调入口`AbstractAutowireCapableBeanFactory#initializeBean`

+Bean的后置处理器,是一个监听器,可以监听容器触发的事件。将它向IOC容器注册后,容器中管理的Bean具备了接收IOC容器事件回调的能力。BeanPostProcessor是一个接口类,有两个接口方法,postProcessBeforeInitialization提供Bean初始化前的回调入口;postProcessAfterInitialization 提供Bean初始化后的回调入口`AbstractAutowireCapableBeanFactory#initializeBean`,这个类可以对项目中的Bean进行修饰,所有Bean都会调用该实现。

### BeanDefinition 的实现

@@ -32,7 +32,7 @@ Spring通过`refresh()`方法对容器进行初始化和资源的载入

第二个过程是BeanDefinition载入,把定义好的Bean表示成IOC容器的内部数据结构BeanDefinition,通过定义BeanDefinition来管理应用的各种对象及依赖关系,其是容器实现依赖反转功能的核心数据结构

-第三个过程是BeanDefinition注册,容器解析得到BeanDefinition后,需要在容器中注册,这由IOC实现BeanDefinitionRegistry接口来实现,注册过程是IOC容器内部维护了一个ConcurrentHasmap来保存得到的BeanDefinition。如果某些Bean设置了lazyinit属性,Bean的依赖注入会在这个过程预先完成,而不需要等到第一次使用Bean的时候才触发。

+第三个过程是BeanDefinition注册,容器解析得到BeanDefinition后,需要在容器中注册,这由IOC实现BeanDefinitionRegistry接口来实现,注册过程是IOC容器内部维护了一个ConcurrentHasmap来保存得到的BeanDefinition。如果某些Bean设置了lazyinit=false属性,Bean的依赖注入会在这个过程预先完成,而不需要等到第一次使用Bean的时候才触发。

### Spring DI(依赖注入)的实现

@@ -51,7 +51,7 @@ getBean()方法定义在BeanFactory接口中,具体实现在子类AbstractBean

5. 通过populateBean注入Bean属性,并调用init-method初始化方法

6. 注册实例化的Bean

-### Spring如何解决循环依赖问题

+### Spring如何解决循环依赖问题(三级缓存)

比如A依赖B, B依赖A.

@@ -131,7 +131,7 @@ AOP面向切面编程,可以通过预编译和运行时动态代理,实现

### Spring MVC运行流程

-image-20190910155238902

+image-20190910155238902

1. 客户端请求到DispatcherServlet

2. DispatcherServlet根据请求地址查询映射处理器HandleMapping,获取Handler

@@ -193,6 +193,64 @@ TransactionTemplate 事务模版是对原始事务管理方式的封装,原始

事务模版主要通过execute(TransactionCallback action)来执行事务,TransactionCallback 有两种方式一种是有返回值TransactionCallback,一种是没有返回值TransactionCallbackWithoutResult。

+手动处理事务的方法:

+

+1. 使用TransactionTemplate

+

+```java

+@Autowired

+private TransactionTemplate transactionTemplate;

+

+public void manualTransaction() {

+ transactionTemplate.execute(status -> {

+ try {

+ // 业务逻辑代码

+ // ...

+

+ // 手动提交

+ // 不需要显式调用,execute方法成功完成后会自动提交

+ return result; // 返回执行结果

+ } catch (Exception e) {

+ // 手动回滚

+ status.setRollbackOnly();

+ throw e; // 或者处理异常

+ }

+ });

+}

+```

+

+

+

+2. 使用PlatformTransactionManager

+

+```java

+@Autowired

+private PlatformTransactionManager transactionManager;

+

+public void manualTransactionWithManager() {

+ // 定义事务属性

+ DefaultTransactionDefinition def = new DefaultTransactionDefinition();

+ def.setPropagationBehavior(TransactionDefinition.PROPAGATION_REQUIRED);

+

+ // 开启事务

+ TransactionStatus status = transactionManager.getTransaction(def);

+

+ try {

+ // 业务逻辑代码

+ // ...

+

+ // 手动提交

+ transactionManager.commit(status);

+ } catch (Exception e) {

+ // 手动回滚

+ transactionManager.rollback(status);

+ throw e; // 或者处理异常

+ }

+}

+```

+

+

+

### Spring 事务底层原理

1. 事务的准备

@@ -255,13 +313,13 @@ TTI:空闲期,即一个数据多久没被访问就从缓存中移除的时

### Spring Cache 注解

-| 注解 | 用法 |

-| ------------ | -------------------------------------------------- |

-| @Cacheable | 先查询缓存,如果没有执行方法并缓存结果,用于取数据 |

-| @CachePut | 先执行方法,然后将返回值放入缓存,用于更新数据 |

-| @CacheEvict | 删除缓存,用于删除数据 |

-| @Caching | 基于前3者的注解数组,多用于一个类有多种实现的情况 |

-| @CacheConfig | 全局缓存注解,用于类上 |

+| 注解 | 用法 |

+| ------------ | ------------------------------------------------------ |

+| @Cacheable | 先查询缓存,如果没有缓存执行方法并缓存结果,用于取数据 |

+| @CachePut | 先执行方法,然后将返回值放入缓存,用于更新数据 |

+| @CacheEvict | 删除缓存,用于删除数据 |

+| @Caching | 基于前3者的注解数组,多用于一个类有多种实现的情况 |

+| @CacheConfig | 全局缓存注解,用于类上 |

缓存管理器

@@ -270,6 +328,32 @@ TTI:空闲期,即一个数据多久没被访问就从缓存中移除的时

3. ConcurrentMapCacheManager 不用配置缓存列表,自动生成缓存ConcurrentMapCache

4. CompositeCacheManager 可以将不同的缓存管理器组合在一起,不同的缓存使用不同的缓存管理器,并且可以通过fallbackToNoOpCache属性回到NoOpCacheManager

+手动处理Spring Cache缓存:

+

+```java

+@Autowired

+private CacheManager cacheManager;

+

+public void manualCacheOperations() {

+ // 获取指定缓存

+ Cache cache = cacheManager.getCache("cacheName");

+

+ // 存入缓存

+ cache.put("key", "value");

+

+ // 获取缓存值

+ ValueWrapper wrapper = cache.get("key");

+ if (wrapper != null) {

+ Object value = wrapper.get();

+ // 使用缓存值

+ }

+

+ // 删除缓存

+ cache.evict("key"); // 删除指定key

+ cache.clear(); // 清空整个缓存

+}

+```

+

### Spring BeanUtils bean拷贝工具用过吗?它是浅拷贝还是深拷贝?怎么实现的?有没有什么坑?其他还有什么bean 拷贝的方法,是浅拷贝还是深拷贝?如何实现深拷贝?

diff --git a/11.Spring Boot.md b/11.Spring Boot.md

old mode 100755

new mode 100644

index f50a1eb..02af055

--- a/11.Spring Boot.md

+++ b/11.Spring Boot.md

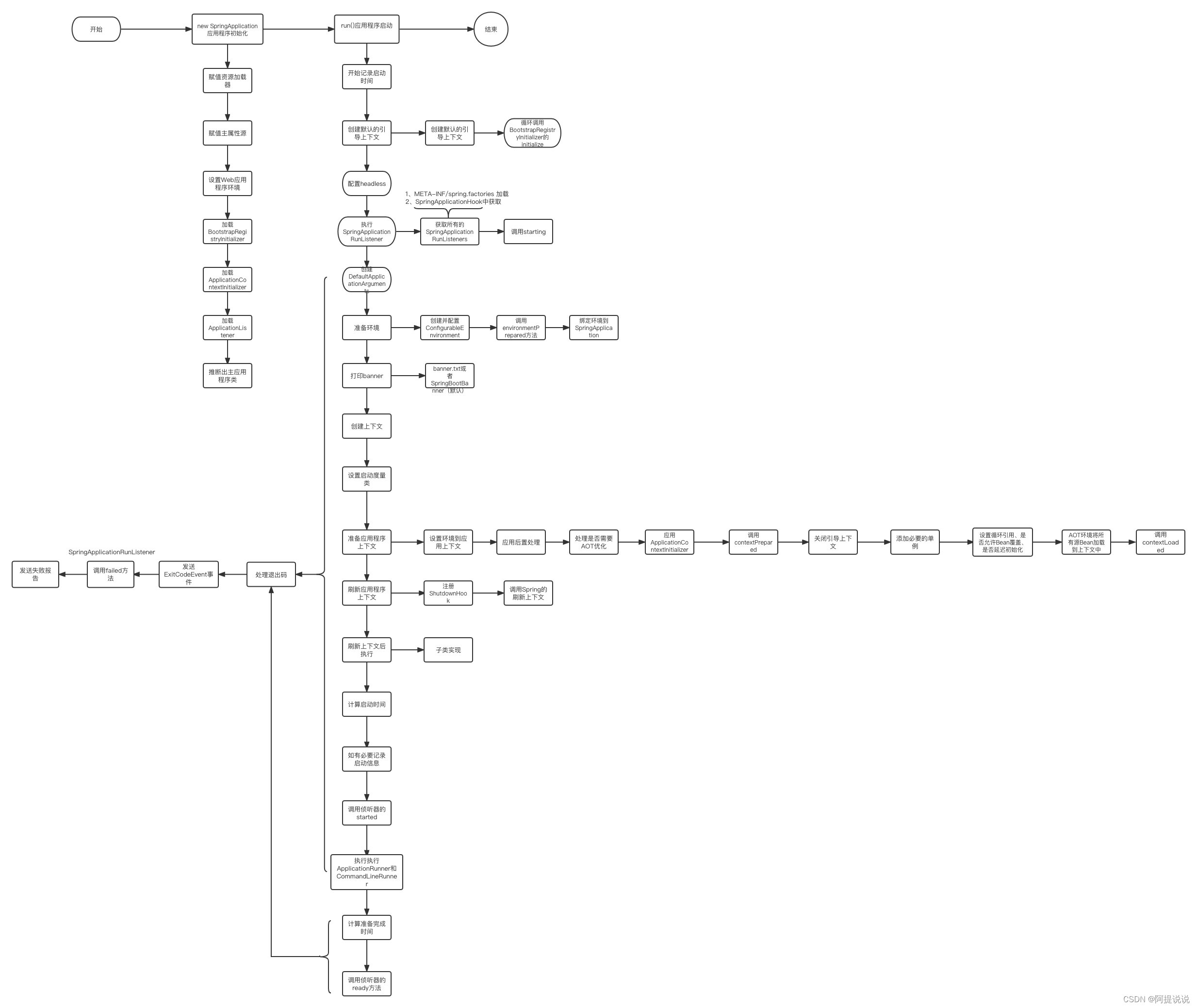

@@ -19,42 +19,39 @@ Spring Boot是 Spring 的子项目,正如其名字,提供 Spring 的引导(

- 判断webApplication是什么类型的

- 设置ApplicationContextInitializer,ApplicationListener,通过加载META-INF/spring.factories中配置的类

- 找到main方法找到启动主类

-

4. run方法中,做的工作

- StopWatch主要是监控启动过程,统计启动时间,检测应用是否已经启动或者停止。

-

- 加载SpringApplicationRunListener(也是通过META-INF/spring.factories),默认加载的是EventPublishingRunListener

-

- - 调用RunListener.starting()方法。

-

- - 根据args创建应用参数解析器ApplicationArguments;

-

+ - 调用RunListener.starting()方法。

+ - 根据args创建应用参数解析器ApplicationArguments;

- 准备环境变量:获取环境变量environment,将应用参数放入到环境变量持有对象中,监听器监听环境变量对象的变化(listener.environmentPrepared)

-

- 打印Banner信息(SpringBootBanner)

-

- 创建SpringBoot的应用上下文(AnnotationConfigEmbeddedWebApplicationContext)

-

- prepareContext上下文之前的准备

-

- refreshContext刷新上下文

-

- afterRefresh(ApplicationRunner,CommandLineRunner接口实现类的启动)

-

- 返回上下文对象

-

+基于SB3.x的启动流程图:

+

+

### Spring Boot启动的时候会加载哪些包?

在web项目中,会在Maven中配置 spring-boot-starter-web 包,该包中包含了spring-core、spring-content、servlet、tomcat、jackson、HikariCP、junit、jdbc、slf4j 等

+### Spring Boot 的监听器

+Spring Boot 的监听器指的是SpringApplicationRunListener和ApplicationListener

-### 如何重新加载 Spring Boot 上的更改,而无需重新启动服务器?

+SpringApplicationRunListener 是Spring Boot 定义的监听器,用于监听 `SpringApplication` 的启动过程,并在**启动的不同阶段执行自定义逻辑**(只在启动阶段)。它允许开发者在应用启动的各个生命周期节点插入自己的代码,例如初始化资源、记录日志、监控启动过程等,通过`META-INF/spring.factories` 文件配置注册。

+

+ApplicationListener是Spring 定义的监听器,能够监听 Spring 容器内发布的 `ApplicationEvent` 事件,覆盖应用的全生命周期,通过作为 Spring Bean 注册(如 `@Component`)、META-INF/spring.factories(org.springframework.context.ApplicationListener)、SpringApplication的addListener和配置文件context.istener.classes

-一共有三种方式,可以实现效果:

+

+

+### 如何重新加载 Spring Boot 上的更改,而无需重新启动服务器?

- 【推荐】`spring-boot-devtools` 插件。注意,这个工具需要配置 IDEA 的自动编译。

@@ -64,6 +61,8 @@ Spring Boot是 Spring 的子项目,正如其名字,提供 Spring 的引导(

- [JRebel](https://www.jianshu.com/p/bab43eaa4e14) 插件,需要付费。

+- 使用插件化开发,插件化代码使用手动注册Bean的方式

+

关于如何使用 `spring-boot-devtools` 和 Spring Loaded 插件,可以看看 [《Spring Boot 学习笔记:Spring Boot Developer Tools 与热部署》](https://segmentfault.com/a/1190000014488100) 。

@@ -71,8 +70,8 @@ Spring Boot是 Spring 的子项目,正如其名字,提供 Spring 的引导(

### 什么是 Spring Boot 自动配置?

1. Spring Boot 在启动时扫描项目所依赖的 jar 包,寻找包含`spring.factories` 文件的 jar 包。

-2. 根据 `spring.factories` 配置加载 AutoConfigure 类。

+2. 根据 `spring.factories` 配置加载 AutoConfigure 类。(Spring Boot 2.7 以后,从META-INF/spring/org.springframework.boot.autoconfigure.AutoConfiguration.imports中加载配置的Jar包)

3. 根据 `@Conditional` 等条件注解的条件,进行自动配置并将 Bean 注入 Spring IoC 中。

-https://my.oschina.net/itsaysay/blog/3011826

+> 详细介绍:https://itsaysay.blog.csdn.net/article/details/131736129

diff --git a/12.Dubbo.md b/12.Dubbo.md

old mode 100755

new mode 100644

diff --git a/13.Spring Cloud.md b/13.Spring Cloud.md

old mode 100755

new mode 100644

index 13286a0..9ee37f4

--- a/13.Spring Cloud.md

+++ b/13.Spring Cloud.md

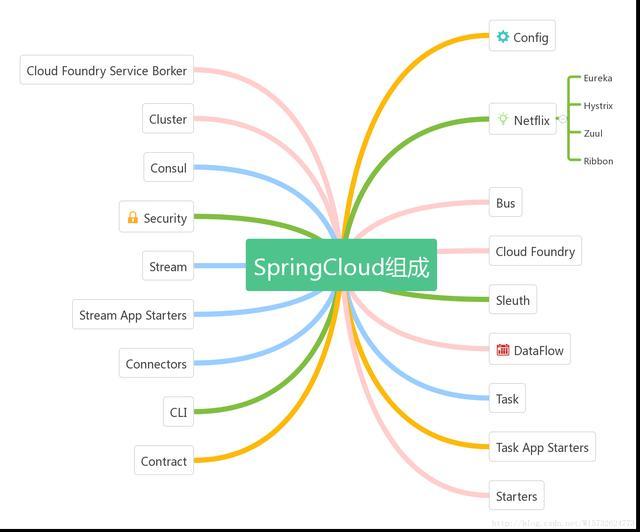

@@ -18,15 +18,15 @@ Spring Cloud 主要提供了如下核心的功能:

脑图如下:

-

+

由于 [Spring Cloud Netflix](https://github.com/spring-cloud/spring-cloud-netflix) 要进入维护模式,下面是一些可以替代组件

-| | Netflix | 阿里 | 其它 |

-| -------- | ------- | -------- | ------------------------------------------------------------ |

-| 注册中心 | Eureka | Nacos | Zookeeper、Consul、Etcd |

-| 熔断器 | Hystrix | Sentinel | Resilience4j |

-| 网关 | Zuul | 暂无 | Spring Cloud Gateway |

+| | Netflix | 阿里 | 其它 |

+| ---- | ------- | -------- | ------------------------------------------------------------------------------------------------------------------------- |

+| 注册中心 | Eureka | Nacos | Zookeeper、Consul、Etcd |

+| 熔断器 | Hystrix | Sentinel | Resilience4j |

+| 网关 | Zuul | 暂无 | Spring Cloud Gateway |

| 负载均衡 | Ribbon | Dubbo | [`spring-cloud-loadbalancer`](https://github.com/spring-cloud/spring-cloud-commons/tree/master/spring-cloud-loadbalancer) |

### Spring Cloud 和 Spring Boot 的区别和关系?

@@ -53,7 +53,7 @@ Spring Cloud 主要提供了如下核心的功能:

### SpringCloud的注册和发现流程,以Eureka为注册中心

-

+img

1. 服务启动时会生成服务的基本信息对象InstanceInfo,然后再启动时注册到服务治理中心

2. 服务注册完成后,会从服务治理中心拉取所有的服务信息,缓存在本地

@@ -100,139 +100,92 @@ Spring Cloud 主要提供了如下核心的功能:

在计算中,负载平衡可以改善跨计算机,计算机集群,网络链接,中央处理单元或磁盘驱动器等多种计算资源的工作负载分布。负载平衡旨在优化资源使用,最大化吞吐量,最小化响应时间并避免任何单一资源的过载。使用多个组件进行负载平衡而不是单个组件可能会通过冗余来提高可靠性和可用性。负载平衡通常涉及专用软件或硬件,例如多层交换机或域名系统服务器进程。

-### Ribbon 有哪些负载均衡算法?

-

-详细文章可见:[《Ribbon 负载均衡策略配置》](https://blog.csdn.net/rickiyeat/article/details/64918756)

-

-其中,默认的负载均衡算法是 Round Robin 算法,顺序向下轮询。

-

-### Ribbon 是怎么和 Eureka 整合的?

-

- Ribbon 原理图:

-

-

-

-- 首先,Ribbon 会从 Eureka Client 里获取到对应的服务列表。

-- 然后,Ribbon 使用负载均衡算法获得使用的服务。

-- 最后,Ribbon 调用对应的服务。

-

-另外,此处的 Eureka 仅仅是作为注册中心的举例,也是可以配合其它的注册中心使用,例如 Zookeeper 。可参考 [《以 Zookeeper 为注册中心搭建 Spring Cloud 环境》](https://www.jianshu.com/p/775c363d0fda) 文章。

-

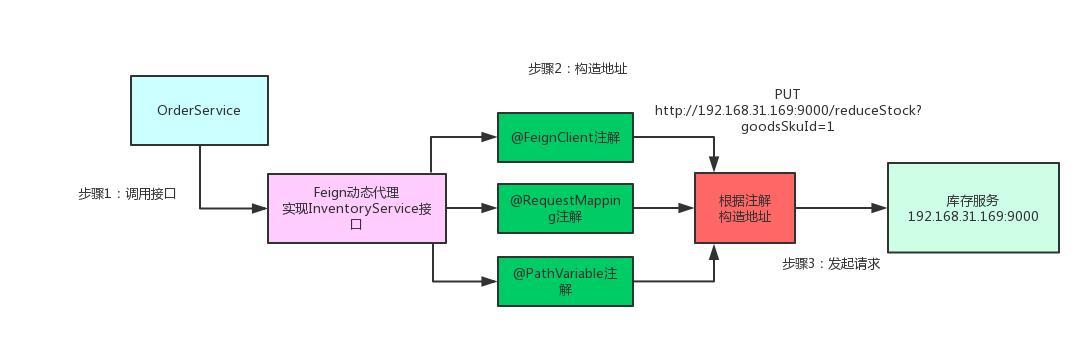

### Feign 实现原理

**Feign的一个关键机制就是使用了动态代理**。咱们一起来看看下面的图,结合图来分析:

- 首先,如果你对某个接口定义了 `@FeignClient` 注解,Feign 就会针对这个接口创建一个动态代理。

- 接着你要是调用那个接口,本质就是会调用 Feign 创建的动态代理,这是核心中的核心。

-- Feig n的动态代理会根据你在接口上的 `@RequestMapping` 等注解,来动态构造出你要请求的服务的地址。

+- Feign的动态代理会根据你在接口上的 `@RequestMapping` 等注解,来动态构造出你要请求的服务的地址。

- 最后针对这个地址,发起请求、解析响应。

-

+

### Feign 和 Ribbon 的区别?

Ribbon 和 Feign 都是使用于调用用其余服务的,不过方式不同。

- 启动类用的注解不同。

- - Ribbon 使用的是 `@RibbonClient` 。

- - Feign 使用的是 `@EnableFeignClients` 。

+ - Ribbon 使用的是 `@RibbonClient` 。

+ - Feign 使用的是 `@EnableFeignClients` 。

- 服务的指定位置不同。

- - Ribbon 是在 `@RibbonClient` 注解上设置。

- - Feign 则是在定义声明方法的接口中用 `@FeignClient` 注解上设置。

+ - Ribbon 是在 `@RibbonClient` 注解上设置。

+ - Feign 则是在定义声明方法的接口中用 `@FeignClient` 注解上设置。

- 调使用方式不同。

- - Ribbon 需要自己构建 Http 请求,模拟 Http 请求而后用 RestTemplate 发送给其余服务,步骤相当繁琐。

- - Feign 采使用接口的方式,将需要调使用的其余服务的方法定义成声明方法就可,不需要自己构建 Http 请求。不过要注意的是声明方法的注解、方法签名要和提供服务的方法完全一致。

-

-### Feign 是怎么和 Ribbon、Eureka 整合的?

-

-

-

-- 首先,用户调用 Feign 创建的动态代理。

-

-- 然后,Feign 调用 Ribbon 发起调用流程。

-

- - 首先,Ribbon 会从 Eureka Client 里获取到对应的服务列表。

-

- - 然后,Ribbon 使用负载均衡算法获得使用的服务。

-

- - 最后,Ribbon 调用 Feign ,而 Feign 调用 HTTP 库最终调用使用的服务。

-

-> 因为 Feign 和 Ribbon 都存在使用 HTTP 库调用指定的服务,那么两者在集成之后,必然是只能保留一个。比较正常的理解,也是保留 Feign 的调用,而 Ribbon 更纯粹的只负责负载均衡的功能。

-

-想要完全理解,建议胖友直接看如下两个类:

-

-- [LoadBalancerFeignClient](https://github.com/spring-cloud/spring-cloud-openfeign/blob/master/spring-cloud-openfeign-core/src/main/java/org/springframework/cloud/openfeign/ribbon/LoadBalancerFeignClient.java) ,Spring Cloud 实现 Feign Client 接口的二次封装,实现对 Ribbon 的调用。

-

-- [FeignLoadBalancer](https://github.com/spring-cloud/spring-cloud-openfeign/blob/master/spring-cloud-openfeign-core/src/main/java/org/springframework/cloud/openfeign/ribbon/FeignLoadBalancer.java) ,Ribbon 的集成。

-

-> 集成的是 AbstractLoadBalancerAwareClient 抽象类,它会自动注入项目中所使用的负载均衡组件。

-

-- LoadBalancerFeignClient =》调用=》 FeignLoadBalancer 。

-

-### Hystrix 隔离策略?

-

-Hystrix 有两种隔离策略:

-

-- 线程池隔离

-- 信号量隔离

-

-实际场景下,使用线程池隔离居多,因为支持超时功能。

-

-详细的,可以看看 [《Hystrix 的资源隔离策略》](https://blog.csdn.net/liuchuanhong1/article/details/73718794) 文章。

-

-#### 聊聊 Hystrix 缓存机制?

+ - Ribbon 需要自己构建 Http 请求,模拟 Http 请求而后用 RestTemplate 发送给其余服务,步骤相当繁琐。

+ - Feign 采使用接口的方式,将需要调使用的其余服务的方法定义成声明方法就可,不需要自己构建 Http 请求。不过要注意的是声明方法的注解、方法签名要和提供服务的方法完全一致。

-Hystrix 提供缓存功能,作用是:

-

-- 减少重复的请求数。

-- 在同一个用户请求的上下文中,相同依赖服务的返回数据始终保持一致。

-

-详细的,可以看看 [《Hystrix 缓存功能的使用》](https://blog.csdn.net/zhuchuangang/article/details/74566185) 文章。

-

-### 什么是 Hystrix 断路器?

-

-Hystrix 断路器通过 HystrixCircuitBreaker 实现。

+### 为什么要网关服务?

-HystrixCircuitBreaker 有三种状态 :

+使用网关服务,我们实现统一的功能:

-- `CLOSED` :关闭

-- `OPEN` :打开

-- `HALF_OPEN` :半开

+- 动态路由

+- 灰度发布

+- 健康检查

+- 限流

+- 熔断

+- 认证: 如数支持 HMAC, JWT, Basic, OAuth 2.0 等常用协议

+- 鉴权: 权限控制,IP 黑白名单,同样是 OpenResty 的特性

+- 可用性

+- 高性能

-其中,断路器处于 `OPEN` 状态时,链路处于**非健康**状态,命令执行时,直接调用**回退**逻辑,跳过**正常**逻辑。

+### 熔断和降级区别

-HystrixCircuitBreaker 状态变迁如下图 :

+熔断是下层服务一旦产生故障就断掉;降级需要对服务进行分级,把产生故障的服务丢掉,换一个轻量级的方案。

-

-- **红线**:初始时,断路器处于``CLOSED``状态,链路处于健康状态。当满足如下条件,断路器从``CLOSED``变成``OPEN``

- 状态:

+### Spring Cloud Gateway

- - **周期**( 可配,`HystrixCommandProperties.default_metricsRollingStatisticalWindow = 10000 ms` )内,总请求数超过一定**量**( 可配,`HystrixCommandProperties.circuitBreakerRequestVolumeThreshold = 20` ) 。

-- **错误**请求占总请求数超过一定**比例**( 可配,`HystrixCommandProperties.circuitBreakerErrorThresholdPercentage = 50%` ) 。

-

-- **绿线** :断路器处于 `OPEN` 状态,命令执行时,若当前时间超过断路器**开启**时间一定时间( `HystrixCommandProperties.circuitBreakerSleepWindowInMilliseconds = 5000 ms` ),断路器变成 `HALF_OPEN` 状态,**尝试**调用**正常**逻辑,根据执行是否成功,**打开或关闭**熔断器【**蓝线**】。

+#### 过滤器

-### 什么是 Hystrix 服务降级?

+分类:

-在 Hystrix 断路器熔断时,可以调用一个降级方法,返回相应的结果。当然,降级方法需要配置和编码,如果不需要,也可以不写,也就是不会有服务降级的功能。

+1、 GatewayFilter,网关过滤器,只应用在单个路由或者一个分组的路由上

-具体的使用方式,可以看看 [《通过 Hystrix 理解熔断和降级》](https://blog.csdn.net/jiaobuchong/article/details/78232920) 。

+- AddRequestHeader:用于在请求头中添加自定义键值对

+- AddRequestParameter:用于在请求中添加请求参数的键值对

+- AddResponseHeader:用于在响应头中添加键值对

+- Hystrix网关过滤工厂:用于将断路器引入网关路由中

+- PrefixPath:用于使用简单的Prefix参数

+- PreserveHostHeader:用于设置路由过滤器的请求属性,检查是否发送原始主机头或由HTTP客户端确定主机头

+- RequestRateLimiter:用于确定当前请求是否允许继续,如果不允许,返回提示"HTTP 429 - Too Many Requests"

+- RedirectTo:用于接收请求的状态和URL参数,该状态是一个重定向的300系列的HTTP代码,如301,URL是Location的头部值

+- RemoveNonProxyHeaders:用于从转发的请求中删除请求头

+- RemoveRequestHeader:用于删除请求头,需要请求头名

+- RemoveResponseHeader:用于响应头,需要响应头名

+- RewritePath:用于使用Java正则表达式重写请求路径

+- SaveSession:用于在转发下游调用之前强制执行保存Session操作

+- SecureHeaders:用于为响应添加安全头

+- SetPath:允许通过路径的模版段来操作请求的路径,使用了Spring框架的URI模版,支持多种匹配

+- SetResponseHeader:用于设置响应头,需要有一个Key-Value对

+- SetStatus:用于设置请求响应状态,需要一个Status参数,该参数的值必须是有效的SpringHttpStatus,

+- StripPrefix:用于剥离前缀,需要parts参数,表明在请求被发送到下游之前从请求路径中剥离的元素数量

+- Retry:用于重试

+- RequestSize:用于限制请求的大小,当请求超过限制时启用,限制请求到达下游服务,该过滤器将RequestSize作为参数

-### 为什么要网关服务?

+2、 GlobalFilter,全局过滤器,应用在所有的路由上

-使用网关服务,我们实现统一的功能:

+- Forward Routing Filter

+- LoadBalancerClientFilter

+- Netty Routing Filter

+- Netty Write Response Filter

+- RouteToRequestUrl Filter

+- Websocket Routing Filter

+- GateWay Metrics Filter 网关指标过滤器

+- Combined Global Filter and GateWayFilter 组合式全局过滤器和网关过滤器排序

+- Marking An Exchange As Routed 路由交换

-- 动态路由

-- 灰度发布

-- 健康检查

-- 限流

-- 熔断

-- 认证: 如数支持 HMAC, JWT, Basic, OAuth 2.0 等常用协议

-- 鉴权: 权限控制,IP 黑白名单,同样是 OpenResty 的特性

-- 可用性

-- 高性能

+> 详细见:[Spring Cloud Gateway 参考指南_cloud: gateway: metrics: enabled: true-CSDN博客](https://blog.csdn.net/weixin_40972073/article/details/125840118?ops_request_misc=%7B%22request%5Fid%22%3A%22171941508116800184151243%22%2C%22scm%22%3A%2220140713.130102334.pc%5Fblog.%22%7D&request_id=171941508116800184151243&biz_id=0&utm_medium=distribute.pc_search_result.none-task-blog-2~blog~first_rank_ecpm_v1~rank_v31_ecpm-1-125840118-null-null.nonecase&utm_term=gateway&spm=1018.2226.3001.4450)

-详细的,可以看看 [《为什么微服务需要 API 网关?》](http://dockone.io/article/2033) 。

diff --git a/14.Message Queue.md b/14.Message Queue.md

old mode 100755

new mode 100644

index 2201513..a7777b5

--- a/14.Message Queue.md

+++ b/14.Message Queue.md

@@ -8,6 +8,18 @@

Kafka是一款高性能的消息中间件,包括Producer,Consumer,Broker,以及Zookeeper,Zookeeper用来负责集群元数据管理,控制器的选举等操作,Producer将消息发送到Broker,由Broker负责将收到的消息存储到磁盘中,Consumer负责从Broker订阅并消费消息。Kafka中的消息是以主题为单位,主题可以分布在不同的分区,分区可以分布于不同的Broker,分区有Leader 与副本follower,follower负责从leader同步数据,leader负责读写请求

+从4.0.0开始彻底去掉了Zookeeper,转为使用 KRaft 模式

+

+| 特性 | Zookeeper 模式 | KRaft 模式 |

+| ------------------ | ---------------------------------------- | --------------------------------------------- |

+| **元数据存储** | 存储在 Zookeeper 中(内存 + 磁盘) | 存储在 Controller 节点的本地磁盘(Raft 日志) |

+| **控制器选举** | 由 Zookeeper 协调选举 | 基于 Raft 协议自主选举(Leader 节点即控制器) |

+| **元数据更新效率** | 需通过网络请求 Zookeeper,延迟较高 | 本地元数据直接更新,延迟低(毫秒级) |

+| **集群扩展性** | Zookeeper 集群扩容复杂,易成瓶颈 | 支持动态添加 Controller 节点,扩展性更好 |

+| **启动速度** | 需等待 Zookeeper 和 Kafka 双重初始化 | 仅需启动 Kafka 节点,启动更快 |

+| **数据一致性保障** | 依赖 Zookeeper 的 Paxos 协议 | 基于 Raft 协议,强一致性更易理解和维护 |

+| **安全性** | 需分别配置 Kafka 和 Zookeeper 的安全策略 | 统一的安全配置(如 SSL、SASL) |

+

#### 消息的幂等性处理思路

@@ -63,6 +75,16 @@ kafka保证消息可靠性,可以通过如下几个配置:

+#### 怎么保证消息顺序消费

+

+消息要顺序消费的场景,比如发送了一个用户新增的消息,随后用户修改了发送了一个修改的消息,最后又删除了发送了一个删除的消息,由于Kafka的多分区,多消费者,消费端势必会变成无序消费,但消费端业务需要顺序处理,如果先消费了删除消息,根本没数据,随后又消费了新增消息,最后消息没有删除,变成了脏数据。

+

+解决方法是:

+

+- 生产者发送消息的时候,根据用户id指定分区key,指定后kafka会将消息发送到指定的分区中,这样保证了分区中消息的顺序。消费端,可以使用单线程从指定分区中消费,如果要保证性能,消费端定义多个内存队列,将相同用户id的消息发送到同一个内存队列中,然后开启多线程从来消费多个内存队列,一个线程处理一个内存队列

+

+- 让消费者只消费一个指定的分区,速度会变慢

+

#### kafka的分区策略

消费者客户端参数partition.assignment.strategy 来配置消费分区策略

@@ -70,3 +92,90 @@ kafka保证消息可靠性,可以通过如下几个配置:

2. RoundRobinAssignor 轮询分配策略

3. StickyAssignor 能够使分区的分配尽可能与上一次保持一致,避免过度重分配

4. 自定义分配,实现PartitionAssignor接口

+

+

+

+#### kafka 集群如何搭建

+

+- 安装zk集群,修改各个节点的kafka配置文件server.properties(broker.id、listeners、zookeeper.connect)

+- 启动zk、启动kafka

+

+k8s 上创建:[K8s - 安装部署Kafka、Zookeeper集群教程(支持从K8s外部访问) - 蜂蜜log - 博客园 (cnblogs.com)](https://www.cnblogs.com/fengyuanfei/p/17789107.html)

+

+

+

+#### 什么是ISR

+

+- AR(Assigned Repllicas)一个partition的所有副本(即使replica,不区分leader或follower)

+- ISR(In-Sync Replicas)能够和leader保持同步的follower+leader本身组成的集合

+- OSR(Out-Sync Relipcas)不能和leader 保持同步的follower集合

+

+### RocketMQ

+

+#### RocketMQ的核心组件是什么

+

+NameServer: 轻量级服务发现中心,管理Broker的地址路由信息;无状态,支持快速扩容

+

+Broker: 消息存储和转发节点,负责接收生产者消息、持久化存储、投递给消费者;主从架构,支持同步/异步复制

+

+Producer: 消息生产者,通过NameServer找到目标Broker发送消息,支持同步、异步、单向发送模式

+

+Consumer: 消息消费者,从Broker拉取消息,支持集群消费和广播消费

+

+#### RocketMQ 的消息模型有哪些

+

+- 点对点(Queue模型):

+

+ 消息通过队列存储,同一消费者组内竞争消费(每条消息仅被一个消费者处理)

+

+- 发布/订阅(Pub-Sub):

+

+- 延迟消息

+- 顺序消息

+

+ 通过MessageQueueSelector 保证同一业务键(如订单ID)的消息发送到同一队列,消费者按队列顺序消费

+

+#### RocketMQ 如何保证消息不丢失

+

+1. 生产者端:同步发送+重试机制;事务消息

+

+2. Broker端:消息持久化,同步刷盘或异步刷盘;同步复制,保证Slave写入成功后才返回ACK

+

+3. 消费者端:手动提交消费偏移量;消费失败重试

+

+#### RocketMQ 怎么实现顺序消息

+

+生产者:通过MessageQueueSelector 将同一业务键(如订单ID)的消息发送到同一队列

+

+Broker:单个队列内的消息天然有序

+

+消费者:单线程消费队列(或锁保证并发安全),并且关闭异步提交消费偏移量

+

+#### 如何解决消息堆积问题

+

+1. 扩容消费者:增加消费者实例数(不超过队列数),提升并行消费能力

+2. 调整消费逻辑:优化消费代码(如批量处理,异步)

+3. 跳过非关键消息:在业务允许时,重置消费偏移量到最新位置

+

+#### 事务消息的实现原理

+

+RokectMQ支持在分布式场景下保障消息生产和本地事务的最终一致性。

+

+1. **第一阶段(发送半消息)**:

+ - 生产者发送"半消息"(对消费者不可见)到 Broker。

+ - Broker 返回 ACK 确认半消息持久化成功。

+2. **第二阶段(执行本地事务)**:

+ - 生产者执行本地事务(如数据库操作),生成事务状态(提交/回滚)。

+3. **Broker 回调检查**:

+ - 若生产者未响应,Broker 定期回调查询本地事务状态。

+4. **最终提交/回滚**:

+ - 根据事务状态提交(投递消息)或回滚(丢弃消息)。

+

+### RabbitMQ

+

+#### 说一下RabbitMQ

+

+RabbitMQ 是一个开源的消息代理软件,核心有Producer(生产者)、Consumer(消费者)、Queue(队列)、Exchange(交换机)、Binding(绑定)、Message(消息),交换机类型有:Fanout(广播到所有绑定的队列)、Direct(精确匹配路由键)、Topic(基于通配符的路由)、Headers(通过消息头属性匹配),另外有死信队列(DLX)可以处理失败或超时的消息,用来实现延时消息

+

+

+

diff --git a/15.Mybatis.md b/15.Mybatis.md

old mode 100755

new mode 100644

index 28cce8c..4c4d323

--- a/15.Mybatis.md

+++ b/15.Mybatis.md

@@ -62,7 +62,7 @@

-#####Mybatis 的 XML Mapper文件中,不同的 XML 映射文件,id 是否可以重复?

+### Mybatis 的 XML Mapper文件中,不同的 XML 映射文件,id 是否可以重复?

不同的 XML Mapper 文件,如果配置了 `"namespace"` ,那么 id 可以重复;如果没有配置 `"namespace"` ,那么 id 不能重复。毕竟`"namespace"` 不是必须的,只是最佳实践而已。

diff --git a/16.Zookeeper.md b/16.Zookeeper.md

old mode 100755

new mode 100644

index caef830..c16f716

--- a/16.Zookeeper.md

+++ b/16.Zookeeper.md

@@ -1,4 +1,6 @@

-# 16.Zookeeper

+# 16.注册中心

+

+## Zookeeper

### Zookeeper 是什么?

@@ -200,4 +202,51 @@ Zookeeper 的选举算法有两种:一种是基于 basic paxos 实现的,另

FastLeaderElection 算法通过异步的通信方式来收集其它节点的选票,同时在分析选票时又根据投票者的当前状态来作不同的处理,以加快 Leader 的选举进程。

- 流程

\ No newline at end of file

+ 流程

+

+## Nacos

+

+### Nacos 与 Eureka、Consul、Zookeeper 等注册中心有何区别?

+

+| 特性 | Nacos | Eureka | Consul | Zookeeper |

+| :----------- | :------------------------- | :---------- | :------------ | :--------- |

+| 一致性协议 | AP + CP 可切换 | AP | CP | CP |

+| 健康检查 | TCP/HTTP/MYSQL/Client Beat | Client Beat | TCP/HTTP/gRPC | Keep Alive |

+| 负载均衡 | 权重/metadata/Selector | Ribbon | Fabio | - |

+| 配置中心 | 支持 | 不支持 | 支持 | 支持 |

+| 雪崩保护 | 支持 | 支持 | 不支持 | 不支持 |

+| 自动注销实例 | 支持 | 支持 | 支持 | 支持 |

+| 访问协议 | HTTP/DNS | HTTP | HTTP/DNS | 客户端 |

+| 监听支持 | 支持 | 支持 | 支持 | 支持 |

+| 多数据中心 | 支持 | 支持 | 支持 | 不支持 |

+| 跨注册中心 | 支持 | 不支持 | 支持 | 不支持 |

+| 易用性 | 简单 | 简单 | 中等 | 复杂 |

+

+Nacos 的优势在于:

+

+- 同时支持服务发现和配置管理

+- 支持 AP 和 CP 两种模式切换

+- 提供更丰富的健康检查机制

+- 支持权重路由等更灵活的路由策略

+- 提供更友好的管理界面

+

+### Nacos 如何实现配置的动态更新?其原理是什么?

+

+1. **客户端长轮询机制**:

+ - 客户端发起配置查询请求时,会携带配置的 MD5 值

+ - 服务端比较客户端 MD5 和服务端 MD5:

+ - 如果相同,服务端会保持连接,直到配置发生变化或超时(默认 30s)

+ - 如果不同,立即返回最新配置

+2. **服务端配置变更处理**:

+ - 当管理员通过控制台或 API 更新配置时

+ - 服务端更新配置并计算新 MD5

+ - 服务端检查所有保持的长轮询连接

+ - 向相关客户端发送配置变更通知

+3. **客户端处理更新**:

+ - 客户端收到变更通知后,立即拉取最新配置

+ - 更新本地缓存和内存中的配置值

+ - 触发配置变更回调(如果有注册监听器)

+4. **监听器机制**:

+ - 应用可以注册配置监听器

+ - 当配置变更时,监听器会被触发

+ - 应用可以在监听器中实现自定义逻辑

\ No newline at end of file

diff --git a/17.Maven.md b/17.Maven.md

old mode 100755

new mode 100644

diff --git a/18.Open Question.md b/18.Open Question.md

old mode 100755

new mode 100644

index 6b4198b..75a2ece

--- a/18.Open Question.md

+++ b/18.Open Question.md

@@ -1,16 +1,12 @@

# 18.开放题

-##### 假设一个场景,要求stop the world时间非常短,你会怎么设计垃圾回收机制?

+### 假设一个场景,要求stop the world时间非常短,你会怎么设计垃圾回收机制?

STW时间短即要求应用响应时间快,应用的绝大多数对象都存在年轻代中,并且能够活到GC的对象很少,所以采用复制算法,只需要复制少量的对象就可以完成收集,同时将年轻代大小调大,通过-Xmn设置。由于年轻代分为Eden区和两个Survivor区,大部分新生对象都存在Eden区,因此还可以通过-XX:SurvivorRatio 调大Eden区的比例,比如-XX:SurvivorRatio=4,表示两个Survivor区与一个Eden区的比值为2:4

+### 现在有一个A类,其中有A、B、C方法,C方法中调用了A、B,定义了一个A、B方法的日志切面,请问能打印出日志吗?

-

-##### 现在有一个A类,其中有A、B、C方法,C方法中调用了A、B,定义了一个A、B方法的日志切面,请问能打印出日志吗?

-

-

-

-##### 分级代理问题

+### 分级代理问题

某公司销售一款智能硬件柜机,内含多种可消费的服务。

@@ -27,9 +23,17 @@ STW时间短即要求应用响应时间快,应用的绝大多数对象都存

2. 假设订单成功消息将触发onTransactionSuccess( ... )方法,请给出(...)部分的必要参数列表

3. 写出onTransactionSuccess方法的伪代码,调用#1列出的方法完成分成逻辑

+### 设计短链接问题

+https://blog.csdn.net/xlgen157387/article/details/80026452

+

+

+

+### TCP连接如何保证安全

+

+TCP 连接只要有IP+端口就可以,首先要保证连接的安全性,通过TLS对TCP的传输数据进行加密。

+

+防止报文重放:TCP连接后,由平台生成一个随机秘钥下发给客户端,每次数据传输都对数据进行签名,接收方对签名进行校验,计算规则可以是:data+timeStamp+signKey,接收方首先会校验时间戳有效性(比如30秒内有效),接着校验数据签名,签名不一致表示报文数据可能有篡改。

-##### 设计短链接问题

-https://blog.csdn.net/xlgen157387/article/details/80026452

diff --git a/19.Distribute_MicroService.md b/19.Distribute_MicroService.md

old mode 100755

new mode 100644

index 472a466..98922cc

--- a/19.Distribute_MicroService.md

+++ b/19.Distribute_MicroService.md

@@ -30,7 +30,11 @@ Soft-state:在基于client-server模式的系统中,server端是否有状态

Eventually consistent:数据最终一致性

+### CAP 为什么只能满足两项

+由于分布式系统中存在网络的不稳定因素(网络故障、丢包等),因此在分布式系统中P(分区容错性)是首先要满足的。此时,如果要保证C(一致性),当A更新了数据,必须等待B同步更新数据才能响应客户端,如果中间出现网络问题,就不能响应客户端,这时就无法保证A(可用性);

+

+如果要保证A(可用性),就需要立即响应客户端,但A、B数据可能会不一致,无法保证C(一致性)

### 微服务与 SOA 的区别

@@ -80,7 +84,7 @@ SOA即面向服务架构,关注点是服务,现有的分布式服务化技

1. 2PC两阶段提交

- 分准备阶段、提交阶段,由事务管理协调器发起

+ 分**准备阶段、提交阶段**,由事务管理协调器发起

准备阶段:事务管理器向参与者发起指令,参与者评估自己的状态,如果参与者评估指令可以完成,则会写redo或者undo日志,然后锁定资源,执行操作,但并不提交。如果其中一个参与者返回准备准备失败,则协调者向参与者发起中止指令,参与者取消已经变更的事务,执行undo日志,释放锁定的资源

@@ -140,6 +144,13 @@ SOA即面向服务架构,关注点是服务,现有的分布式服务化技

Paxos 算法运行在运行宕机故障的异步系统中,它不要求可靠的消息传递,也容忍消息丢失,延迟,乱序和重复,它利用大多数机制保证了"2F+1"的容错能力,即"2F+1"个节点的系统最多允许F个节点同时出现故障

+### Seata 支持事务模式

+

+1. AT模式,基于2PC实现,适用高并发、对性能敏感的业务场景

+2. TCC模式,基于TCC实现,侵入业务,需要实现TCC的逻辑

+3. Saga模式,基于Saga实现,适用业务流程长的场景

+4. XA模式,基于XA协议(2PC实现),适用使用XA模式的老应用迁移到Seata平台,以及AT模式未适配的数据库应用

+

### 说说达到最终一致性的方案

1. 查询模式,通过查询了解调用服务的最终处理情况,决定下一步做什么

@@ -158,8 +169,29 @@ SOA即面向服务架构,关注点是服务,现有的分布式服务化技

如果实例服务是分布式部署,需要将同一请求路由到同一个实例,可以通过某个请求参数的hash路由,也可以通过Nginx的hash路由功能

- https://blog.csdn.net/dustin_cds/article/details/79595297

+ https://blog.csdn.net/dustin_cds/article/details/79595297

+

+### 架构设计原则

+

+要保持模块模块大小适中,尽可能减少调用深度,多扇入少扇出,保持高内聚低耦合,单入口、单出口,模块的作用域要在模块内,模块功能是可预测的,另外面向对象设计要遵守如下原则:

+

+- 单一责任原则:一个类只做一种责任类型

+

+比如,一个"用户类"不应同时负责用户信息管理和订单生成,这两项职责应拆分到"用户类"和"订单类"中

+

+- 开放-封闭原则:支持扩展,不支持修改

+

+比如,一个"支付接口"可以通过新增"支付宝实现类","微信支付实现类"来扩展支付方式,而不是修改原有的接口

+

+- 里氏替换原则:子类可以替换父类

+

+比如,一个支付接口,子类无论是"支付宝实现类"还是"微信支付实现类",都能正常实现支付

+

+- 依赖倒置原则:细节依赖抽象

+

+比如,订单服务调用物流服务时,依赖的是物流服务的抽象接口,而非具体的"顺丰物流"、"圆通物流"

+- 接口分离原则:不强迫适用,依赖抽象,不依赖具体

+一个 "多功能设备接口" 不应包含 "打印""扫描""复印" 所有方法,而应拆分为 "打印接口""扫描接口" 等,让仅需打印功能的客户端只依赖 "打印接口"

-###

\ No newline at end of file

diff --git a/2.Java Concurrent.md b/2.Java Concurrent.md

old mode 100755

new mode 100644

index 9b138ec..d78dcfd

--- a/2.Java Concurrent.md

+++ b/2.Java Concurrent.md

@@ -6,7 +6,7 @@

### 运行中的线程能否强制杀死

-Jdk提供了stop()方法用于强制停止线程,但官方并不建议使用,因为强制停止线程会导致线程使用的资源,比如文件描述符、网络连接处于不正常的状态。建议使用标志位的方式来终止线程,如果线程中有使用无限期的阻塞方式,比如wait()没有设置超时时间,就只能使用interrupt()方法来终止线程

+Jdk提供了stop()方法用于强制停止线程,但官方并不建议使用,因为强制停止线程会导致线程使用的资源,比如文件描述符、网络连接处于不正常的状态。建议使用标志位的方式来终止线程,如果线程中有使用无限期的阻塞方式,比如wait()没有设置超时时间,就只能使用interrupt()方法来终止线程

```java

@SneakyThrows

@@ -39,15 +39,24 @@ class Thread1 extends Thread{

### ThreadLocal 子类及原理, OOM产生原因及防治

- InheritableThreadLocal

-

- 继承了ThreadLocal,并重写childValue、getMap、createMap,对该类的操作实际是对线程ThreadLocalMap的操作

-

+ 继承了ThreadLocal,并重写childValue、getMap、createMap,对该类的操作实际是对线程ThreadLocalMap的操作。

子线程能够读取父线程数据,实际原因是新建子线程的时候,会从父线程copy数据

+

+> 使用场景:子线程能够访问父线程设置的信息

-- OOM原因及防治

+- ThreadLocal原理及OOM原因及防治

ThreadLocal只是一个工具类,具体存放变量的是线程的threadLocals变量,threadLocals是一个ThreadLocalMap类型的变量,内部是一个Entry数组,Entry继承自WeakReference,Entry内部的value用来存放通过ThreadLocal的set方法传递的值,key是ThreadLocal的弱引用,key虽然会被GC回收,但value不能被回收,这时候ThreadLocalMap中会存在key为null,value不为null的entry项,如果时间长了就会存在大量无用对象,造成OOM。虽然set,get也提供了一些对Entry项清理的时机,但不及时,`所以在使用完毕后需要及时调用remove`

-

- https://www.cnblogs.com/micrari/p/6790229.html

+

+> 源码分析:[ThreadLocal源码解读](源码分析/ThreadLocal.md) 源码分析/ThreadLocal.md

+

+### 分布式系统中使用ThreadLocal 要注意的问题

+

+- 跨服务调用,ThreadLocal存储的数据丢失

+

+通过协议头(HTTP Header、RPC元数据)携带ThreadLocal中存储的数据,接收方在将协议头中的数据重新设置到本地ThreadLocal中

+

+- 线程池复用,导致数据污染

+ 无论是否使用线程池,都在数据使用完毕后,调用ThreadLocal.remove(),避免复用污染

### 有哪些并发队列

@@ -56,8 +65,11 @@ LinkedBlockingQueue: 有界阻塞队列,使用单向链表实现,通过Reent

ArrayBlockingQueue: 有界数组方式实现的阻塞队列 , 通过ReentrantLock实现线程安全,阻塞通过Condition实现,出队和入队使用同一把锁

PriorityBlockingQueue: 带优先级的无界阻塞队列,内部使用平衡二叉树堆实现,遍历保证有序需要自定排序

DelayQueue: 无界阻塞延迟队列,队列中的每个元素都有个过期时间,当从队列获取元素时,只有过期元素才会出队列,队列头元素是最快要过期的元素

-SynchronousQueue: 任何一个写需要等待一个读的操作,读操作也必须等待一个写操作,相当于数据交换 https://www.cnblogs.com/dwlsxj/p/Thread.html

-LinkedTransferQueue: 由链表组成的无界阻塞队列,多了tryTransfer 和 transfer方法。transfer方法,能够把生产者元素立刻传输给消费者,如果没有消费者在等待,那就会放入队列的tail节点,并阻塞等待元素被消费了返回,可以使用带超时的方法。tryTransfer方法,会在没有消费者等待接收元素的时候马上返回false

+SynchronousQueue: 任何一个写需要等待一个读的操作,读操作也必须等待一个写操作,相当于数据交换

+

+> [SynchronousQueue原理详解-公平模式](源码分析/SynchronousQueue.md) 源码分析/SynchronousQueue.md

+

+LinkedTransferQueue: 由链表组成的无界阻塞队列,多了tryTransfer 和 transfer方法。transfer方法,能够把生产者元素立刻传输给消费者,如果没有消费者在等待,那就会放入队列的tail节点,并**阻塞**等待元素被消费了返回,可以使用带超时的方法。tryTransfer方法,会在没有消费者等待接收元素的时候**马上返回false**

LinkedBlockingDeque: 由链表组成的双向阻塞队列,可以从队列的两端插入和移除元素

@@ -65,27 +77,18 @@ LinkedBlockingDeque: 由链表组成的双向阻塞队列,可以从队列的

- 构造参数:

corePoolSize: 线程池核心线程个数

-

maximunPoolSize: 线程池最大线程数量

-

keeyAliveTime: 空闲线程存活时间

-

TimeUnit: 存活时间单位

-

workQueue: 用于保存等待执行任务的阻塞队列

-

ThreadFactory: 创建线程的工厂

RejectedExecutionHandler: 队列满,并且线程达到最大线程数量的时候,对新任务的处理策略,AbortPolicy(抛出异常)、CallerRunsPolicy(使用调用者所在线程执行)、DiscardOldestPolicy(调用poll丢弃一个任务,执行当前任务)、DiscardPolicy(默默丢弃、不抛异常)

-

+

- 原理:

线程池主要是解决两个问题:

-

一个是当执行大量异步任务时能够提供较好的性能,能复用线程处理任务;

-

二是能够对线程池进行资源限制和管理。

-

一个任务提交的线程池,首先会判断核心线程池是否已满,未满就会创建worker线程执行任务,已满判断阻塞队列是否已满,阻塞队列未满加入阻塞队列,已满就判断线程池线程数量是否已经达到最大值,没有就新建线程执行任务,达到最大值的话执行拒绝策略。

-

拒绝策略有:直接抛出异常、使用调用者所在线程执行、丢弃一个旧任务,执行当前任务、直接丢弃什么都不做。

- 创建线程池的方式:直接new ThreadPoolExecutor 或者通过Executors工具类创建

@@ -97,7 +100,7 @@ LinkedBlockingDeque: 由链表组成的双向阻塞队列,可以从队列的

3. newCachedThreadPool 创建一个核心线程数为0,最大线程为Inter.MAX_VALUE的线程池,也就是说没有限制,线程池中的线程数量不确定,但如果有空闲线程可以复用,则优先使用,如果没有空闲线程,则创建新线程处理任务,处理完放入线程池

4. newSingleThreadScheduledExecutor 创建只有一个线程的可以定时执行的线程池

5. newScheduledThreadPool 创建一个没有最大线程数限制的可以定时执行线程池

-6. newWorkStealingPool 创建一个含有足够多线程的线程池,能够调用闲置的CPU去处理其他的任务,使用ForkJoinPool实现,jdk8新增

+6. newWorkStealingPool 创建一个含有足够多线程的线程池,能够调用闲置的CPU去处理其他的任务,使用ForkJoinPool实现,jdk8新增(线程数量根据当前系统的可用处理器核心数(逻辑核心),默认值等于系统的逻辑核心数量)

### 线程池的阻塞队列为什么都用LinkedBlockingQueue,而不用ArrayBlockingQueue

@@ -113,7 +116,7 @@ ArrayBlockingQueue 使用数组实现,在声明的时候必须指定长度,

如CPU密集型的任务,基本线程池应该配置多大?IO密集型的任务,基本线程池应该配置多大?用有界队列好还是无界队列好?任务非常多的时候,使用什么阻塞队列能获取最好的吞吐量?

-CPU密集型,为了充分使用CPU,减少上下文切换,线程数配置成CPU个数+1个即可

+CPU密集型,为了充分使用CPU,减少上下文切换,线程数配置成CPU个数+1个即可(线程数略多于核心数可避免因个别线程偶尔阻塞导致的CPU闲置,同时避免过多上下文切换)

IO密集型,由于可能大部分线程在处理IO,IO都比较耗时,因此可以配置成 2*CPU个数的线程,去处理其他任务

@@ -206,83 +209,83 @@ public class CopyOnWriteArrayListTest {

- CountDownLatch:

使用AQS实现,通过AQS的状态变量state来作为计数器值,当多个线程调用countdown方法时实际是原子性递减AQS的状态值,当线程调用await方法后当前线程会被放入AQS阻塞队列等待计数器为0再返回

-

- ```java

- public class CountDownLatchTest {

-

- public static final CountDownLatch countDownLatch = new CountDownLatch(2);

-

- ExecutorService executor = Executors.newFixedThreadPool(2);

-

- @Test

- public void test1() throws InterruptedException {

- executor.submit(() -> {

- System.out.println(Thread.currentThread().getName() + " step1");

- countDownLatch.countDown();

- });

- executor.submit(() -> {

- System.out.println(Thread.currentThread().getName() + " step2");

- countDownLatch.countDown();

- });

-

- countDownLatch.await();

- System.out.println("thread end");

- }

- }

- ```

-

- ```

- pool-1-thread-1 step1

- pool-1-thread-2 step2

- thread end

- ```

-

-

+

+ ```java

+ public class CountDownLatchTest {

+

+ public static final CountDownLatch countDownLatch = new CountDownLatch(2);

+

+ ExecutorService executor = Executors.newFixedThreadPool(2);

+

+ @Test

+ public void test1() throws InterruptedException {

+ executor.submit(() -> {

+ System.out.println(Thread.currentThread().getName() + " step1");

+ countDownLatch.countDown();

+ });

+ executor.submit(() -> {

+ System.out.println(Thread.currentThread().getName() + " step2");

+ countDownLatch.countDown();

+ });

+

+ countDownLatch.await();

+ System.out.println("thread end");

+ }

+ }

+ ```

+

+ ```

+ pool-1-thread-1 step1

+ pool-1-thread-2 step2

+ thread end

+ ```

+

+

- CyclicBarrier:

区别:CountDownLatch计数器是一次性的,变为0后就起不到线程同步的作用了。而CyclicBarrier(撒克里克巴瑞儿)在计数器变为0后重新开始,通过调用await方法,能在所有线程到达屏障点后统一执行某个任务,再执行完后继续执行子线程,通过ReentrantLock实现

-

- ```java

- public class CyclicBarrierTest {

-

- public static final CyclicBarrier cycle = new CyclicBarrier(3);

-

- ExecutorService executorService = Executors.newFixedThreadPool(2);

-

- @Test

- public void test1() throws BrokenBarrierException, InterruptedException {

- executorService.submit(() -> {

- System.out.println(Thread.currentThread().getName());

- try {

- cycle.await();

- System.out.println(Thread.currentThread().getName() + ",执行结束");

- } catch (InterruptedException | BrokenBarrierException e) {

- e.printStackTrace();

- }

- });

-

- executorService.submit(() -> {

- System.out.println(Thread.currentThread().getName());

- try {

- Thread.sleep(3000);

- cycle.await();

- System.out.println(Thread.currentThread().getName() + ",执行结束");

- } catch (InterruptedException | BrokenBarrierException e) {

- e.printStackTrace();

- }

- });

- cycle.await();

- }

- }

- ```

-

- ```

- pool-1-thread-1

- pool-1-thread-2

- pool-1-thread-2,执行结束

- pool-1-thread-1,执行结束

- ```

-

+

+ ```java

+ public class CyclicBarrierTest {

+

+ public static final CyclicBarrier cycle = new CyclicBarrier(3);

+

+ ExecutorService executorService = Executors.newFixedThreadPool(2);

+

+ @Test

+ public void test1() throws BrokenBarrierException, InterruptedException {

+ executorService.submit(() -> {

+ System.out.println(Thread.currentThread().getName());

+ try {

+ cycle.await();

+ System.out.println(Thread.currentThread().getName() + ",执行结束");

+ } catch (InterruptedException | BrokenBarrierException e) {

+ e.printStackTrace();

+ }

+ });

+

+ executorService.submit(() -> {

+ System.out.println(Thread.currentThread().getName());

+ try {

+ Thread.sleep(3000);

+ cycle.await();

+ System.out.println(Thread.currentThread().getName() + ",执行结束");

+ } catch (InterruptedException | BrokenBarrierException e) {

+ e.printStackTrace();

+ }

+ });

+ cycle.await();

+ }

+ }

+ ```

+

+ ```

+ pool-1-thread-1

+ pool-1-thread-2

+ pool-1-thread-2,执行结束

+ pool-1-thread-1,执行结束

+ # 等待所有线程都执行完成

+ ```

### Phaser 的实现

@@ -307,7 +310,7 @@ public class PhaserTest {

executor.submit(() -> {

System.out.println(Thread.currentThread().getName() + " step2");

- phaser.arrive(d);

+ phaser.arrive();

});

//等同await()

@@ -401,39 +404,40 @@ Thread2:1

什么时候使用volatile?

+- 有一个变量,这个变量需要被多线程检查某个条件,此时使用volatile确保每次都从主内存读取

+

- 写入变量值不依赖变量的当前值。因为如果依赖当前值,将是获取-计算-写入三步操作,这三步操作不是原子性的,而volatile不保证原子性

- 读写变量值时没有加锁。因为加锁已经保证了内存可见性,没必要再使用volatile

-

volatile不能保证原子性

-

- ```java

- public class VolatileTest {

-

- public volatile int inc = 0;

-

- public void increase() {

- inc++;

- }

-

- public static void main(String[] args) {

- final VolatileTest test = new VolatileTest();

-

- for(int i = 0; i < 10; i++) { - new Thread(() -> {

- for(int j = 0; j < 1000; j++) - test.increase(); - }).start(); - } - //保证前面的线程都执行完 - while (Thread.activeCount()> 1)

- Thread.yield();

-

- System.out.println(test.inc);

- }

- }

- //输出:<=10000 - ``` + + ```java + public class VolatileTest { + + public volatile int inc = 0; + + public void increase() { + inc++; + } + + public static void main(String[] args) { + final VolatileTest test = new VolatileTest(); + + for(int i = 0; i < 10; i++) { + new Thread(() -> {

+ for(int j = 0; j < 1000; j++) + test.increase(); + }).start(); + } + //保证前面的线程都执行完 + while (Thread.activeCount()> 1)

+ Thread.yield();

+

+ System.out.println(test.inc);

+ }

+ }

+ //输出:<=10000 + ``` ### 伪共享 @@ -443,8 +447,6 @@ Thread2:1> @Contended注解只用于Java核心类,如果用户类路径下的类要使用这个注解,需要添加JVM参数:-XX:-RestrictContended。默认填充宽度为128,需要自定义宽度设置 -XX:ContendedPaddingWidth参数

-> CPU缓存行详细说明:https://mp.weixin.qq.com/s/yosnZr0bDdLrhmpnX8TY5A

-

### 原子操作类

**AtomicBoolean**

@@ -456,19 +458,15 @@ Thread2:1

整型的原子操作类,1.8后提供函数式操作的方法

- int getAndUpdate(IntUnaryOperator updateFunction)

-

使用指定函数计算并更新,返回计算前结果

- int updateAndGet(IntUnaryOperator updateFunction)

-

使用指定函数计算并更新,返回计算后的结果

- int getAndAccumulate(int x,IntBinaryOperator accumulatorFunction)

-

使用指定的函数计算x值和当前值,返回计算前结果

- int accumulateAndGet(int x,IntBinaryOperator accumulatorFunction)

-

使用指定的函数计算x值和当前值,返回结算后的结果

```java

@@ -510,15 +508,12 @@ public void atomicIntegerTest() {

提供了原子性更新整型数组元素的方式

- int getAndUpdate(int i, IntUnaryOperator updateFunction)

-

使用指定函数计算i索引的值,返回计算前结果

- int updateAndGet(int i, IntUnaryOperator updateFunction)

-

使用指定函数计算i索引的值,返回计算后结果

- int getAndAccumulate(int i, int x, IntBinaryOperator accumulatorFunction)

-

使用指定的函数计算x值和i索引的值,返回计算前结果

- int accumulateAndGet(int i, int x, IntBinaryOperator accumulatorFunction)

@@ -683,46 +678,53 @@ public void test1() {

AtomicStampedReference解决ABA问题,通过维护一个版本号

```java

-@SneakyThrows

-@Test

-public void test2() {

- AtomicStampedReference atomicStampedReference = new AtomicStampedReference(10,1);

-

- CountDownLatch countDownLatch = new CountDownLatch(2);

+ //AtomicStampedReference,通过维护一个版本号

+ @SneakyThrows

+ @Test

+ public void test2() {

+ AtomicStampedReference atomicStampedReference = new AtomicStampedReference(10,1);

- new Thread(() -> {

- System.out.println(Thread.currentThread().getName() + " 第一次版本:" + atomicStampedReference.getStamp());

- atomicStampedReference.compareAndSet(10, 11, atomicStampedReference.getStamp(), atomicStampedReference.getStamp() + 1);

- System.out.println(Thread.currentThread().getName() + " 第二次版本:" + atomicStampedReference.getStamp());

- atomicStampedReference.compareAndSet(11, 10, atomicStampedReference.getStamp(), atomicStampedReference.getStamp() + 1);

- System.out.println(Thread.currentThread().getName() + " 第三次版本:" + atomicStampedReference.getStamp());

- countDownLatch.countDown();

- }).start();

+ CountDownLatch countDownLatch = new CountDownLatch(2);

- new Thread(() -> {

- System.out.println(Thread.currentThread().getName() + " 第一次版本:" + atomicStampedReference.getStamp());

- try {

- TimeUnit.SECONDS.sleep(2);

- boolean isSuccess = atomicStampedReference.compareAndSet(10,12, atomicStampedReference.getStamp(), atomicStampedReference.getStamp() + 1);

- System.out.println(Thread.currentThread().getName() + " 修改是否成功:" + isSuccess + " 当前版本:" + atomicStampedReference.getStamp() + " 当前值:" + atomicStampedReference.getReference());

+ new Thread(() -> {

+ //使用第一次获取的版本,因为不知道有其他线程偷摸改了

+ int stamp = atomicStampedReference.getStamp();

+ System.out.println(Thread.currentThread().getName() + " 第一次版本:" + stamp);

+ try {

+ //等待一下

+ TimeUnit.SECONDS.sleep(2);

+ //这个线程打算修改10->12

+ boolean isSuccess = atomicStampedReference.compareAndSet(10,12, stamp, stamp + 1);

+ System.out.println(Thread.currentThread().getName() + " 修改是否成功:" + isSuccess + " 当前版本:" + atomicStampedReference.getStamp() + " 当前值:" + atomicStampedReference.getReference());

+ countDownLatch.countDown();

+ } catch (InterruptedException e) {

+ e.printStackTrace();

+ }

+ }).start();

+

+ new Thread(() -> {

+ //这个线程偷摸的把10->11->10

+ System.out.println(Thread.currentThread().getName() + " 第一次版本:" + atomicStampedReference.getStamp());

+ atomicStampedReference.compareAndSet(10, 11, atomicStampedReference.getStamp(), atomicStampedReference.getStamp() + 1);

+ System.out.println(Thread.currentThread().getName() + " 第二次版本:" + atomicStampedReference.getStamp());

+ atomicStampedReference.compareAndSet(11, 10, atomicStampedReference.getStamp(), atomicStampedReference.getStamp() + 1);

+ System.out.println(Thread.currentThread().getName() + " 第三次版本:" + atomicStampedReference.getStamp());

countDownLatch.countDown();

- } catch (InterruptedException e) {

- e.printStackTrace();

- }

- }).start();

+ }).start();

- countDownLatch.await();

-}

+

+ countDownLatch.await();

+ }

```

```java

//输出

+Thread-1 第一次版本:1

Thread-0 第一次版本:1

-Thread-0 第二次版本:2

-Thread-0 第三次版本:3

-Thread-1 第一次版本:3

-Thread-1 修改是否成功:true 当前版本:4 当前值:12

+Thread-1 第二次版本:2

+Thread-1 第三次版本:3

+Thread-0 修改是否成功:false 当前版本:3 当前值:10

```

AtomicMarkableReference 通过标志位,由于其标志位只有true和false,如果每次更新都变更标志位,在第三次的时候标志位还是跟第一次一样,并没有解决ABA问题

@@ -911,7 +913,7 @@ public void LongAccumulatorTest() {

3. BlockingQueue阻塞队列 put() 和take方法

4. Semaphore 基于计数的信号量

5. PipedInputStream / PipedOutputStream 管道输入输出流

-https://blog.csdn.net/ldx19980108/article/details/81707751

+ https://blog.csdn.net/ldx19980108/article/details/81707751

### 说说Random 与 ThreadLocalRandom

@@ -931,3 +933,71 @@ https://www.jianshu.com/p/89dfe990295c

https://blog.csdn.net/m0_37542889/article/details/92640903

+### Lambda表达式和Stream API 的底层实现原理

+

+- Lambda表达式

+

+Java8引入的函数式编程语法糖,依赖函数式接口(只有一个抽象方法的接口),本质是该接口抽象方法的实现,通过invokedynamic 指令和方法句柄(Method Handle)实现动态绑定,能够减少匿名内部类带来的类加载开销和字节码冗余

+

+- Stream API

+

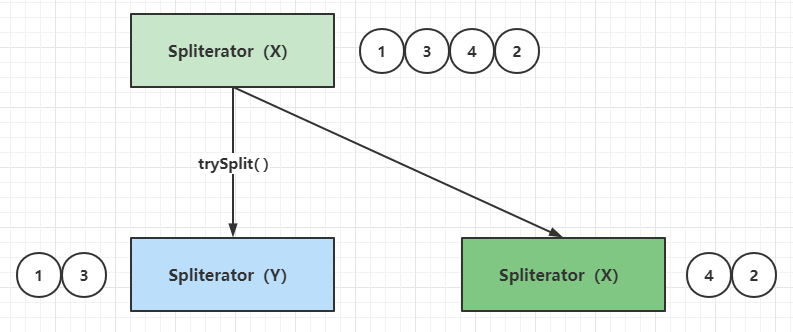

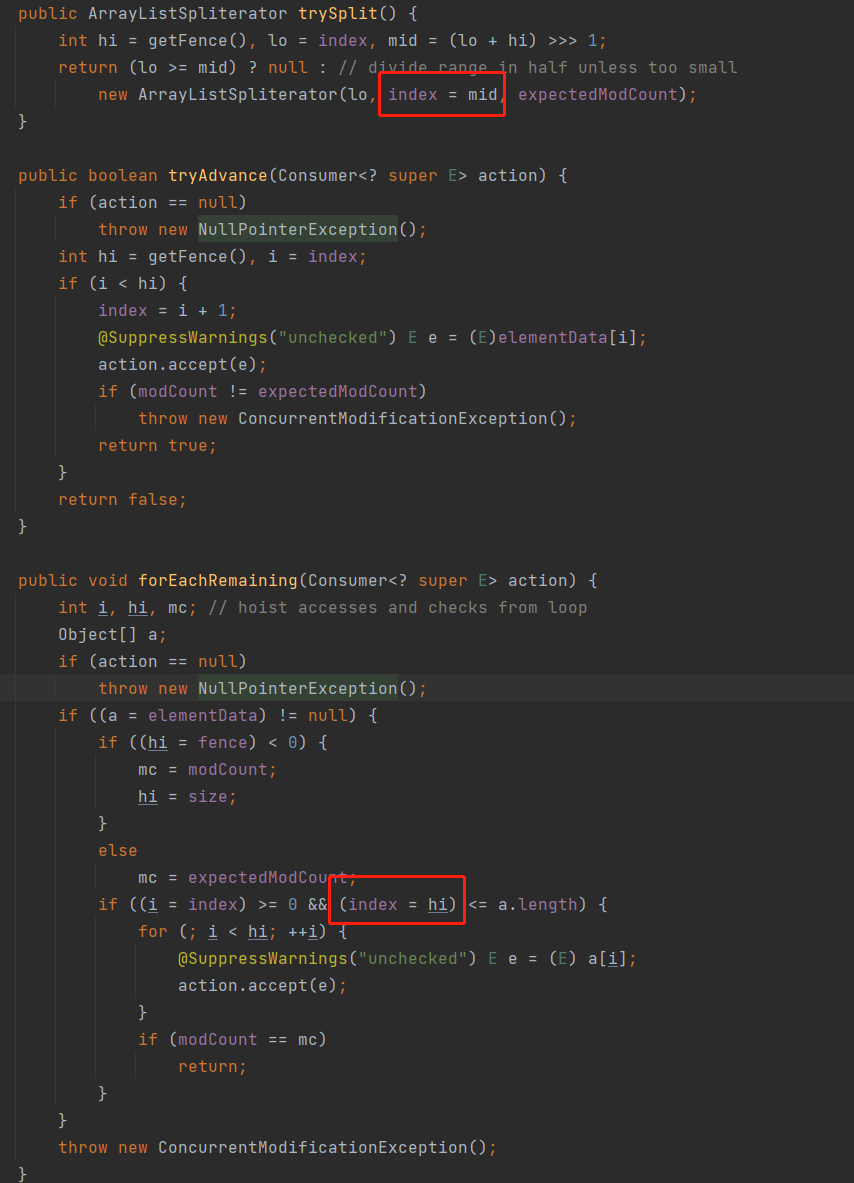

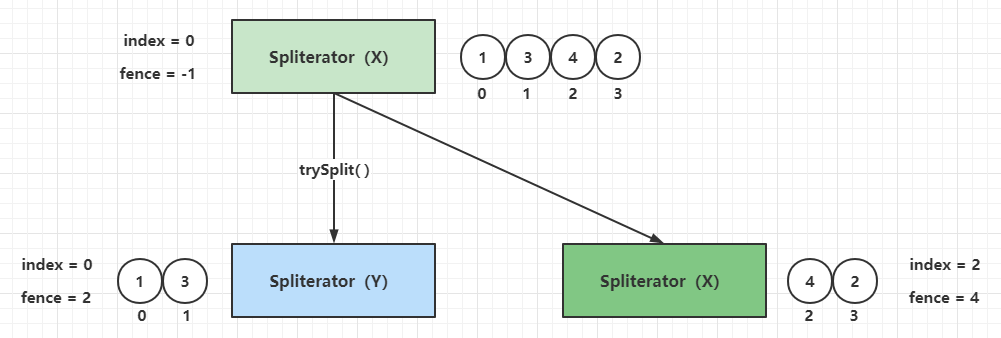

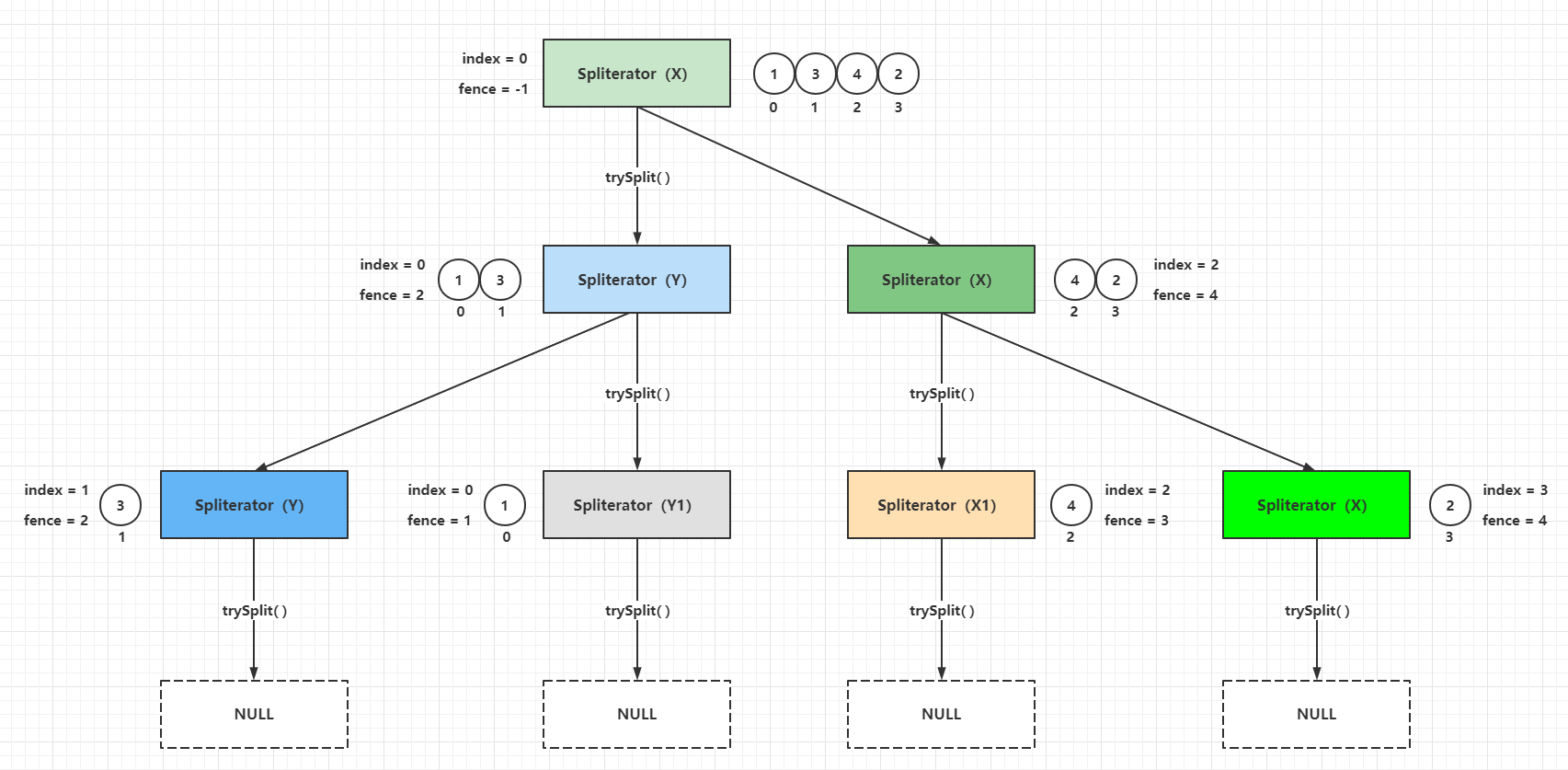

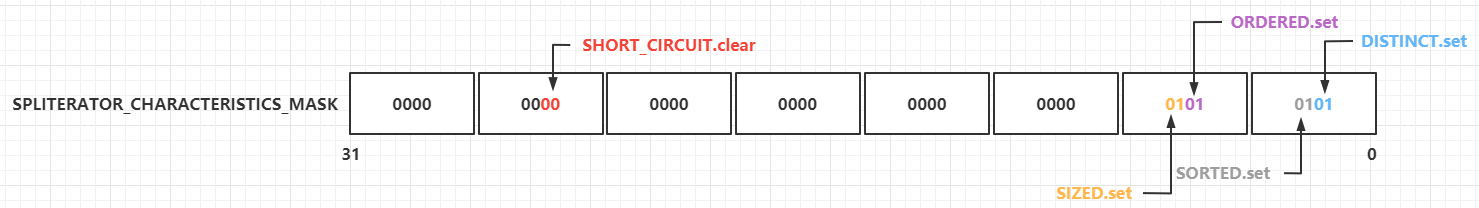

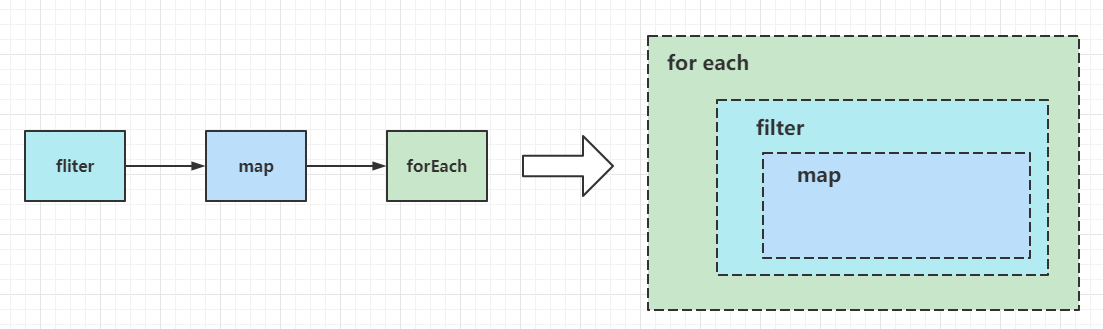

+底层通过Pipeline(流水线)、Spliterator(拆分器)实现,支持串行和并行处理。

+

+Pipeline(流水线)由数据源(如List)、中间操作(如filter、map)和终端操作(如collect、forEach)组成,中间操作是"惰性的",仅记录操作逻辑,不立即执行,到达终点后才遍历数据源,依次执行中间操作

+

+Spliterator 用于拆分数据源的迭代器(支持并行处理),定义了`trySplit()` 方法(拆分数据为子部分)和 `tryAdvance()` 方法(遍历元素)

+

+并行流:基于ForkJoin框架,通过 Spliterator 将数据源拆分为多个子任务,由多个线程并行处理,最后合并结果

+

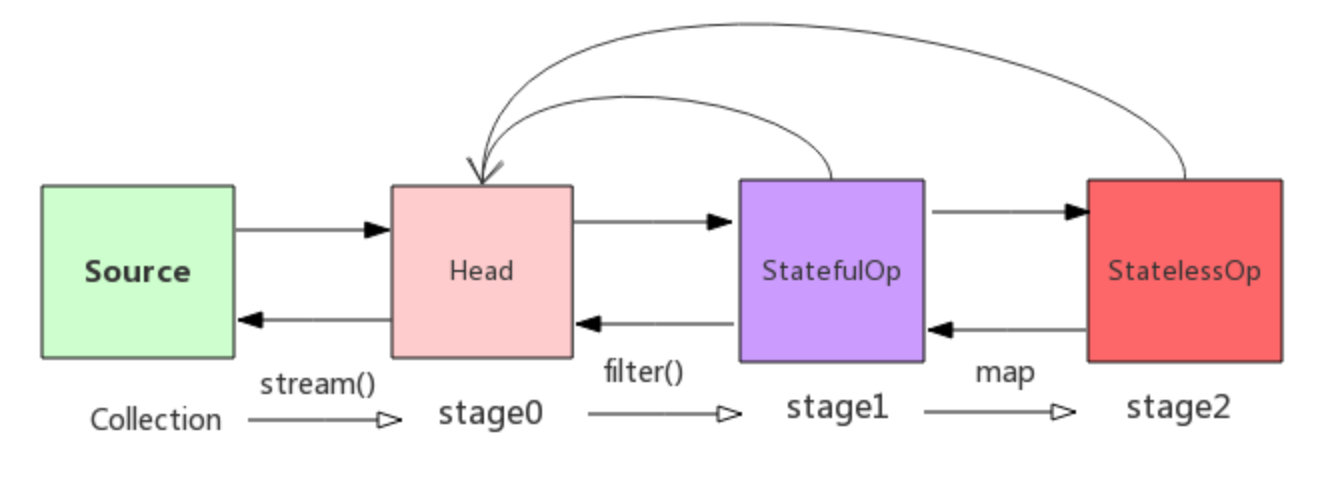

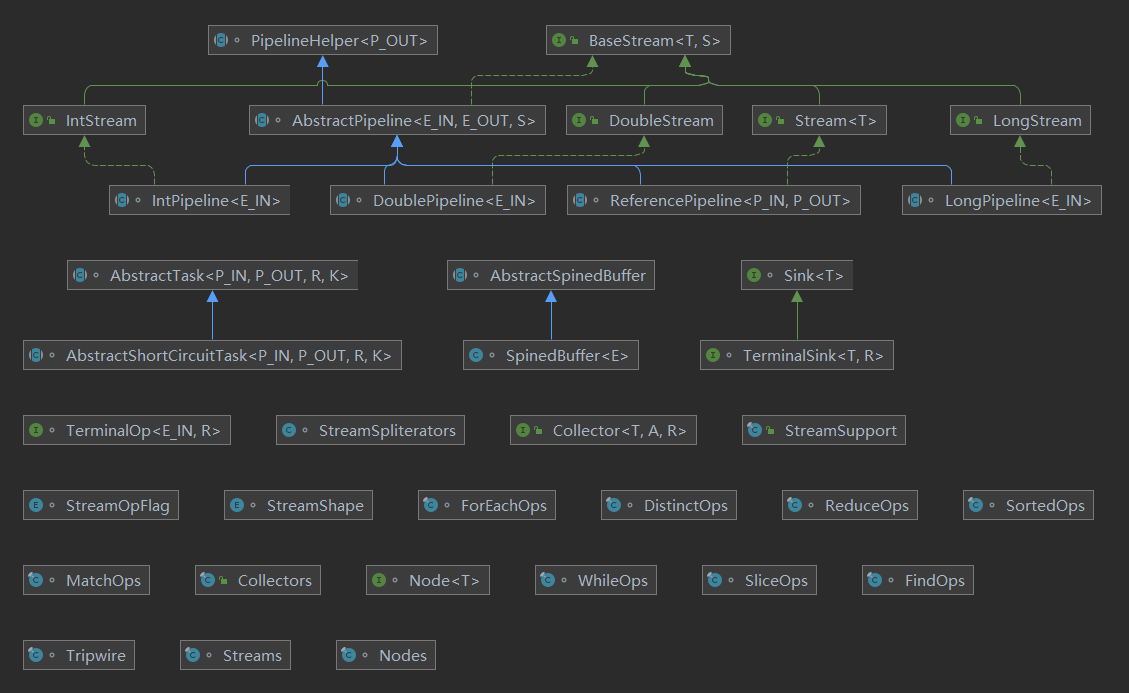

+### 用过流没有,流怎么实现

+

+Stream流是Java8中引入的新特性,Stream有几个特点:

+

+不存数据,都是通过管道将源数据元素传递给操作;

+

+对Stream的任何修改都不会修改数据源,都是新产生一个流

+

+流的很多操作如filter、map都是延迟执行的,只有到终点才会将操作顺序执行

+

+对于无限流可以通过"短路"操作访问到有限元素后就返回

+

+流的元素只访问一次,如果需要重新访问,需要重新生成一个新的流

+

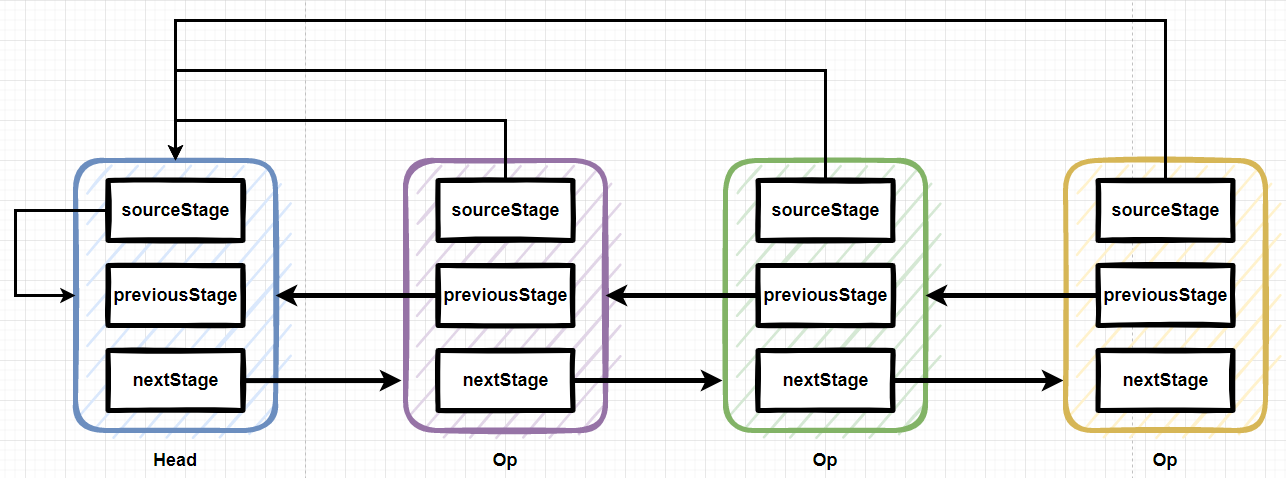

+Stream中BaseStream规定了流的基本接口,在Stream中使用Stage来描述一个完整的操作,将具有先后顺序的各个Stage连一起,就构成了整个流水线。

+

+AbstractPipeline是流水线的核心,定义了三个AbstractPipeline类型的变量:sourceStage(源阶段)、previousStage(上游pipeline,上一阶段),nexStage(下一阶段)

+

+ReferencePipeline 继承了AbstractPipeline

+

+Head、StatefulOp、StatelessOp继承了ReferencePipeline,分别表示源,无状态操作,有状态操作

+

+

+

+比如Collection.stream()方法得到Head也就是stage0,紧接着调用一系列的中间操作,不断产生新的stage。这些stage对象以双向链表的形式组织在一起,构成整个流水线。

+由于每个Stage都记录了前一个Stage和本次的操作以及回调函数,依靠这种结构就建立起对数据源的所有操作。

+

+### parallelStream 怎么实现的并行处理

+

+parallelStream 底层使用ForkJoinPool 实现并行处理,默认线程为可用的CPU数量。

+

+### 解释一下ForkJoin框架

+

+parallelStream的底层是基于ForkJoinPool的,ForkJoinPool实现了ExecutorService接口

+

+Fork/Join框架主要采用分而治之的理念来处理问题,对于一个比较大的任务,首先将它拆分(fork)为多个小任务task1、task2等。再使用新的线程thread1去处理task1,thread2去处理task2。

+

+如果thread1认为task1还是太大,则继续往下拆分成新的子任务task1.1与task1.2。thread2认为task2任务量不大,则立即进行处理,形成结果result2。

+

+之后将task1.1和task1.2的处理结果合并(join)成result1,最后将result1与result2合并成最后的结果。

+

+img

+

+### CompletableFuture 异步编程实现原理

+

+CompletableFuture是Java8引入的异步编程工具,基于回调机制和事件驱动模型实现异步操作,核心原理是:

+

+1. 异步执行任务:通过线程池(默认使用ForkJoinPool)执行异步任务,任务执行期间主线程无需阻塞等待

+2. 回调触发机制:任务完成后,自动触发注册的回调函数(如thenApply、exceptionally等),回调函数在任务完成后由线程池中的线程执行

+3. 链式编程:内部实现CompletionStage接口,允许将多个异步操作串联或并联,形成流水线式的异步处理流程

+

+传统Future 要get()阻塞等待获取结果,或轮询isDone();无法直接串联多个异步任务;难以合并多个独立异步任务的结果。

diff --git a/20.Java Performance.md b/20.Java Performance.md

old mode 100755

new mode 100644

index 5da6730..4088448

--- a/20.Java Performance.md

+++ b/20.Java Performance.md

@@ -244,6 +244,8 @@ jstat -gcutil 31798

-XX:+UseConcMarkSweepGC: 设置CMS收集器

+-XX:+UseZGC: 使用ZGC

+

**垃圾回收统计信息**

@@ -284,7 +286,7 @@ jstat -gcutil 31798

-XX:ParallelGCThreads=n: 设置并发收集器年轻代收集方式为并行收集时,使用的CPU数。并行收集线程数。

--XX:+CMSInitiatingOccupancyFraction: 设置CMS收集器在老年代空间被使用多少后触发,默认68%

+-XX:+CMSInitiatingOccupancyFraction: 设置CMS收集器在老年代空间被使用多少后触发,默认92%

-XX:+UseCMSCompactAtFullCollection: 设置CMS收集器在完成垃圾收集后是否要进行一次内存碎片的整理

@@ -294,24 +296,40 @@ jstat -gcutil 31798

-XX:+CMSParallelRemarkEnabled: 启用并行重标记

+-XX:+CMSParallelInitialMarkEnabled:在初始标记的时候使用多线程

+

-XX:CMSInitiatingPermOccupancyFraction: 当永久区占用率达到这一百分比时,启动CMS回收(前提是开启-XX:+CMSClassUnloadingEnabled)

--XX:UseCMSInitiatingOccupancyOnly: 表示只在到达阈值的时候,才进行CMS回收

+-XX:+UseCMSInitiatingOccupancyOnly: 表示只在到达阈值的时候(-XX:CMSInitiatingPermOccupancyFraction指定的值),才进行CMS回收,如果不指定,JVM仅在第一次使用设定值,后续会自动调整

+

+-XX:+CMSScavengeBeforeRemark:在CMS GC 前启动一次minor gc,目的在于减少老年代对年轻代的引用,降低CMS GC 标记阶段的开销,一般CMS的GC耗时80%都在标记阶段

**G1回收器设置**

--XX:+UseG1GC: 使用G1回收器

+ -XX:+UseG1GC: 使用G1回收器

-XX:+UnlockExperimentalVMOptions: 允许使用实验性参数

--XX:MaxGCPauseMillis: 设置最大垃圾收集停顿时间

+-XX:MaxGCPauseMillis: 设置最大垃圾收集停顿时间(默认200ms)

-XX:GCPauseIntervalMillis: 设置停顿间隔时间

-XX:+DisableExplicitGC: 禁用显示GC

+-XX:ParallelGCThreads:指定GC工作的线程数量

+

+-XX:G1HeapRegionSize: 指定分区大小(1MB-32MB,必须是2的N次幂),默认将整堆划分为2048个分区

+

+-XX:G1NewSizePercent: 新生代内存初始空间(默认整堆5%,值配置整数,默认就是百分比)

+

+-XX:G1MaxNewSizePercent: 新生代内存最大空间

+

+-XX:TargentSurvivorRatio: Survivor区的填充容量(默认50%),Survivor区域里的一批对象总和超过了Survivor区域的50%,此时会把年龄n(含)以上的对象都放入老年代

+

+-XX:MaxTenuringThreshold:最大年龄阈值(默认15)

+

> 更多垃圾回收器参数,见

@@ -540,7 +558,55 @@ the space 69632K, 4% used [0x227d0000, 0x22aeb958, 0x22aeba00, 0x26bd0000)

+### 如何根据业务场景选择合适的垃圾收集器

+

+从延迟、吞吐量、内存大小来考虑。

+

+- #### SerialGC

+

+ - 适用场景:

+ - 堆内存较小(通常 < 1GB)的应用; + - 单核 CPU 或资源受限的环境(如嵌入式设备、简单客户端应用); + - 对延迟不敏感的场景(如本地工具类程序)。 + + - 不适用:服务端应用、多线程高并发场景。 + +- #### ParallelGC + + - 适用场景: + - 对吞吐量要求高,对延迟不敏感的应用(如后台批处理任务、数据分析、科学计算); + - 堆内存中等(1GB ~ 10GB),且 CPU 核心数较多(充分利用多线程加速 GC); + - 不需要低延迟的服务(如离线数据处理)。 + + - 不适用:对响应时间敏感的服务(如 Web 应用、实时交易系统)。 + +- #### CMS + + - 适用场景: + - 对延迟敏感的服务端应用(如 Web 服务器、电商网站、API 服务),需要快速响应用户请求; + - 堆内存中等(1GB ~ 10GB),且 CPU 资源充足(需预留线程处理并发 GC); + - 无法接受长时间 STW 的场景。 + - 不适用: + - 堆内存过大(>10GB)(并发阶段耗时太长,反而可能增加延迟);

+ - CPU 资源紧张的环境(并发阶段会抢占用户线程 CPU);

+ - JDK 9 及以上(CMS 已被标记为 deprecated,JDK 14 移除)。

+- #### G1

+ - 适用场景:

+ - 堆内存较大(4GB ~ 数百 GB)的服务端应用(如企业级应用、中间件、微服务);

+ - 需要平衡吞吐量和延迟的场景(既不能接受过长停顿,也需要一定的吞吐量);

+ - 替代 CMS 的主流选择(JDK 9 后默认 GC)。

+ - 不适用:

+ - 堆内存极小(<4gb)(region 管理的 overhead 不划算); + - 对延迟要求极高(如微秒级响应)的场景(STW 停顿通常在几十到几百毫秒)。 +- #### ZGC + - 适用场景: + - 对延迟要求极高的场景(如高频交易系统、实时数据分析、大型分布式服务); + - 堆内存超大(数十 GB 到 TB 级),且需要快速响应的应用; + - 希望在大内存下保持低延迟的现代服务(如云原生应用)。 + - 不适用: + - JDK 版本过低(需 JDK 11+,且 JDK 15 后才正式可用); + - 对吞吐量要求极致且可接受长停顿的场景(ZGC 为低延迟牺牲了部分吞吐量优化)。 diff --git a/21. Nginx.md b/21. Nginx.md old mode 100755 new mode 100644 diff --git a/22. ShardingJDBC.md b/22. ShardingJDBC.md old mode 100755 new mode 100644 index c09302b..8996851 --- a/22. ShardingJDBC.md +++ b/22. ShardingJDBC.md @@ -1,4 +1,4 @@ -# 22.Sharding-JDBC +# 22.分库分表 [toc] @@ -10,6 +10,8 @@>

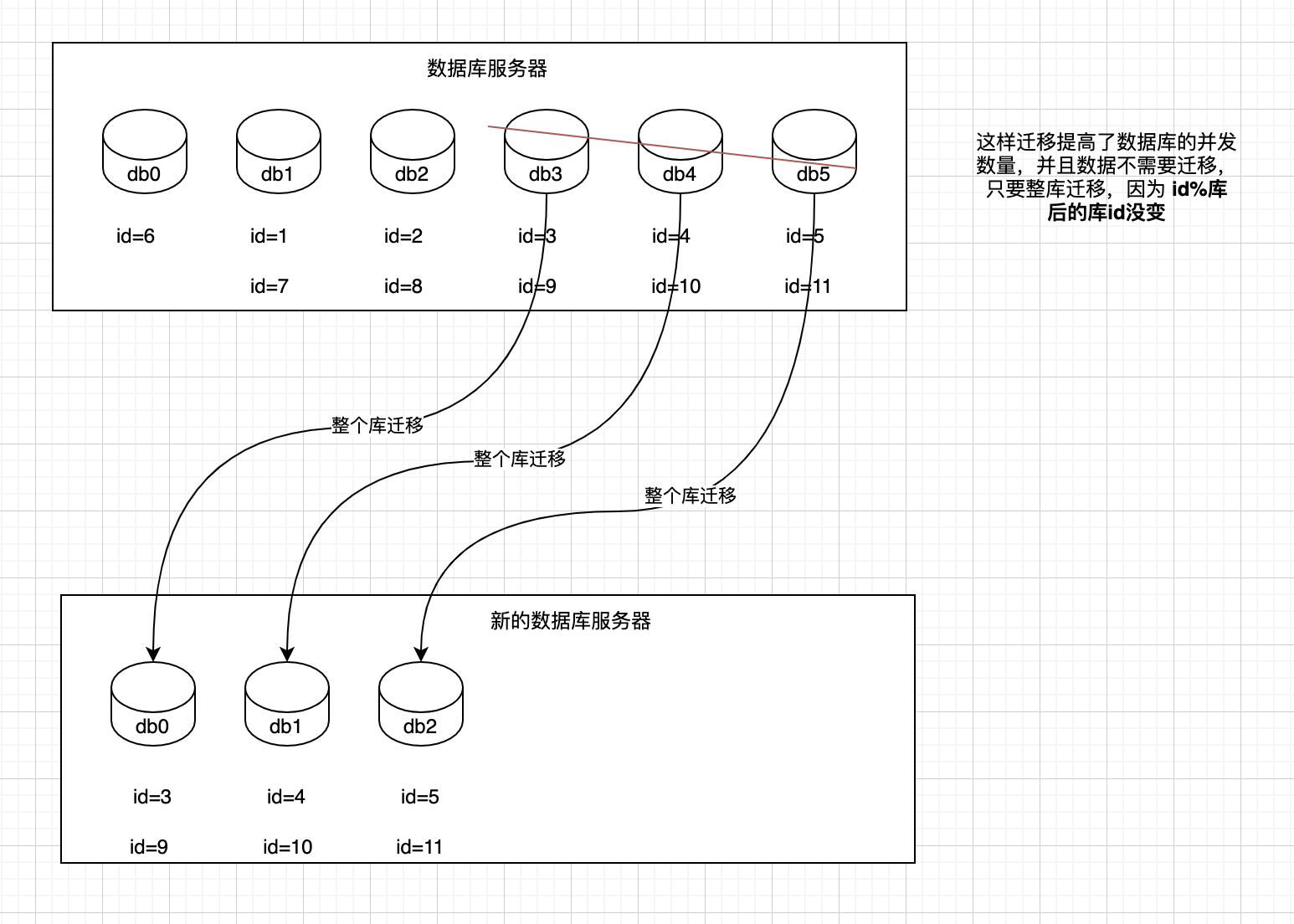

> 数据库分库分表思路:https://www.cnblogs.com/butterfly100/p/9034281.html

+## Sharding-JDBC

+

### 分库分表的方式

- 垂直分库

@@ -248,10 +250,12 @@ mycat:自己上官网,找一个官网最基本的例子,自己写一下,

orderId 模 32 = 库

orderId / 32 模 32 = 表

-259 3 8

-1189 5 5

-352 0 11

-4593 17 15

+orderId 库 表

+

+259 3 8

+1189 5 5

+352 0 11

+4593 17 15

1、设定好几台数据库服务器,每台服务器上几个库,每个库多少个表,推荐是32库 * 32表,对于大部分公司来说,可能几年都够了;

@@ -263,4 +267,6 @@ orderId / 32 模 32 = 表

5、我们这边就是修改一下配置,调整迁移的库所在数据库服务器的地址;

-6、重新发布系统,上线,原先的路由规则变都不用变,直接可以基于2倍的数据库服务器的资源,继续进行线上系统的提供服务。

\ No newline at end of file

+6、重新发布系统,上线,原先的路由规则变都不用变,直接可以基于2倍的数据库服务器的资源,继续进行线上系统的提供服务。

+

+

\ No newline at end of file

diff --git a/23.ES.md b/23.ES.md

new file mode 100644

index 0000000..45d63e7

--- /dev/null

+++ b/23.ES.md

@@ -0,0 +1,62 @@

+# 23.ES

+

+### ES的分布式架构原理

+

+核心思想是在多台机器上启动多个ES进程实例,组成一个ES集群。ES中存储数据的基本单位是索引,用来存储具有共同特性的文档集合,一个索引差不多就相当于Mysql中的表。为了提高可伸缩性和容错性,ES会将索引划分为多个分片,每个分片都是一个独立的Lucene索引,可以部署在集群中的任何节点上,一个索引包含一个或多个主分片和零个或多个副本分片,主分片负责数据的写入,而副本分片则用于数据的容错和读请求的分流。

+

+### ES 的核心概念

+

+- 索引(Index)

+

+类似数据库中的"表",是文档的逻辑集合。每个索引有一个唯一的名称(如products)

+

+- 文档(Document)

+

+索引中的基本数据单元,以JSON格式存储;每个文档有一个唯一ID和类型

+

+- 分片(Shard)

+

+索引被水平拆分的子集,每个分片是一个独立的Lucene索引;

+

+主分片:数据写入的目标分片,数量在索引创建时固定

+

+副本分片:主分片的拷贝,提供高可用和读负载均衡

+

+- 节点(Node)

+

+一个运行的ES实例,可以是数据节点、主节点或协调节点

+

+### ES写入数据的流程

+

+1. 客户端请求:文档发送到协调节点

+2. 路由与分片选择:协调节点根据文档ID的哈希值选择目标分片

+3. 写入主分片:主分片先写入内存缓冲区,同时记录到事务日志(用于崩溃恢复)

+4. 刷新:默认1秒,内存缓冲区的内容生成一个新的段(Segment)并开放搜索

+5. 刷盘:定期将内存中的段持久化到磁盘

+6. 同步副本:主分片将写入操作同步到所有副本分片

+

+### ES 如何实现全文搜索

+

+- 倒排索引:核心数据结构,记录每个词项出现在哪些文档中

+- 分词:将文本转换为词项的过程

+

+**查询流程**:

+

+1. 对查询字符串分词(使用相同的分析器)。

+2. 在倒排索引中匹配词项,计算相关性得分(如 TF-IDF、BM25)。

+3. 返回排序后的文档。

+

+### ES在数据量很大的情况下如何提高性能

+

+1. **索引设计**:

+ - 合理设置分片数(建议单个分片大小 10-50GB)。

+ - 使用 `routing` 将相关文档存到同一分片,减少跨分片查询。

+2. **查询优化**:

+ - 避免 `wildcard` 查询(性能差),改用 `keyword` 类型 + 前缀搜索。

+ - 使用 `filter` 替代 `query` 条件(不计算得分,结果可缓存)。

+3. **硬件与配置**:

+ - 数据节点使用 SSD,内存分配给文件系统缓存(建议不超过 50% 堆内存)。

+ - 调整 `indices.query.bool.max_clause_count` 解决大量 `terms` 查询问题。

+4. **聚合优化**:

+ - 对高基数字段(如用户 ID)使用 `cardinality` 聚合时,开启 `precision_threshold`。

+

diff --git a/24. AI.md b/24. AI.md

new file mode 100644

index 0000000..4f136a5

--- /dev/null

+++ b/24. AI.md

@@ -0,0 +1,15 @@

+# 24. AI

+

+### 大模型聊天中有哪些配置,他们的作用

+

+temperature:较高的温度生成的内容随机性更大,较低的温度会使大模型选择最可能的单词

+

+top_p: 模型从累计概率大于或等于"p"的最小集合中随机选择一个

+

+repetition_penalty: 重复惩罚

+

+### 大模型中有哪几种role,他们的区别

+

+1. system : 用于设定模型的行为规范、背景或任务指令,由开发者或系统设定,用户不可见,内容通常是对模型的隐性提示,如角色设定,回答格式等

+2. user:真实用户的输入,即用户向模型提出的问题或指令

+3. assistant:模型自身的回复,在多轮对话中起到记录历史响应,维持上下文连贯性的作用

\ No newline at end of file

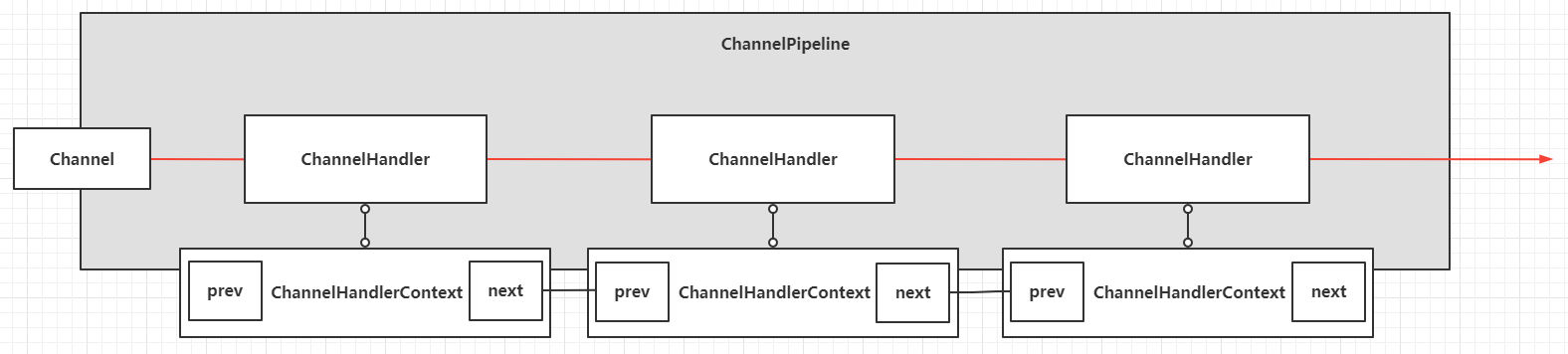

diff --git a/25.Netty.md b/25.Netty.md

new file mode 100644

index 0000000..be839be

--- /dev/null

+++ b/25.Netty.md

@@ -0,0 +1,173 @@

+# 25.Netty

+

+### TCP 的粘包和拆包

+

+TCP 是以流的方式来处理数据的,一个完整的包可能会被TCP拆分成多个包进行发送,也可能把小的封装成一个大的数据包发送。

+

+### BIO、NIO、AIO的区别

+

+BIO:一个连接一个线程,客户端有连接请求时服务器端就需要启动一个线程进行处理,线程开销大。是面向流的,阻塞流,流是单向的。

+

+NIO: 一个请求一个线程,但客户端发送的连接请求都会注册到多路复用器上,多路复用器轮询到连接有IO请求时才启动一个线程进行处理。面向缓存区,非阻塞,channe是双向的。

+

+AIO:一个有效请求一个线程,客户端的IO请求都是由OS先完成了再通知服务器应用去启动线程进行处理

+

+### NIO 的组成

+

+Buffer:与Channel进行交互,数据从Channel读入缓冲区,从缓冲区写入Channel中

+

+flip方法:反转缓冲区,将position给limit,然后将position置为0,就是读写切换

+

+clear方法:清除此缓冲区,将position置为0,把capacity的值给limit

+

+rewind方法:重置此缓冲区,将position置为0

+

+DirectByteBuffer:可减少一次系统空间到用户空间的拷贝

+

+Channel:与数据源的连接,是双向的,只能与Buffer交互

+

+Selector:允许单个线程管理多个Channel

+

+Pipe:两个线程之间的单向数据连接,数据会被写到sink通道,从source通道读取

+

+

+

+NIO服务端建立过程:

+

+1. ServerSocketChannel.open 创建服务端Channel

+2. bind 绑定服务端端口

+3. 配置非阻塞模式

+4. Selector.open 打开一个selector

+5. 注册关注的事件到selector上

+

+```java

+// 服务端代码

+public class NioServer {

+

+ public static void main(String[] args) {

+ try(ServerSocketChannel serverSocketChannel = ServerSocketChannel.open()) {

+ serverSocketChannel.socket().bind(new InetSocketAddress(3388));

+

+ Selector selector = Selector.open();

+ serverSocketChannel.configureBlocking(false);

+ serverSocketChannel.register(selector, SelectionKey.OP_ACCEPT);

+

+ System.out.println("服务器准备就绪,开始监听,端口3388");

+

+

+ while (true) {

+ int wait = selector.select();

+ if (wait == 0)

+ continue;

+

+ Set keys = selector.selectedKeys();

+ Iterator iterator = keys.iterator();

+ ByteBuffer byteBuffer = ByteBuffer.allocate(1024);

+

+ while (iterator.hasNext()) {

+

+ SelectionKey key = iterator.next();

+

+ if (key.isAcceptable()) {

+ ServerSocketChannel server = (ServerSocketChannel) key.channel();

+ SocketChannel channel = server.accept();

+ channel.configureBlocking(false);

+ channel.register(selector, SelectionKey.OP_READ);

+ } else if(key.isReadable()) {

+ SocketChannel server = (SocketChannel) key.channel();

+ int len = server.read(byteBuffer);

+ if (len> 0) {

+ byteBuffer.flip();

+ String content = new String(byteBuffer.array(), 0, len);

+ System.out.println(content);

+

+ server.configureBlocking(false);

+ server.register(selector, SelectionKey.OP_WRITE);

+ }

+ byteBuffer.clear();

+ } else if (key.isWritable()) {

+ SocketChannel server = (SocketChannel) key.channel();

+ server.write(ByteBuffer.wrap("Hello Client!".getBytes()));

+ }

+

+ iterator.remove();

+ }

+

+ }

+

+ } catch (Exception e) {

+ e.printStackTrace();

+ }

+ }

+}

+

+

+//客户端代码

+public class NIOClient {

+

+ public static void main(String[] args) {

+ try(SocketChannel channel = SocketChannel.open()) {

+ channel.connect(new InetSocketAddress(3388));

+

+ //发送数据

+ if (channel.isConnected()) {

+ channel.write(ByteBuffer.wrap("Hello Server!".getBytes()));

+ }

+

+ ByteBuffer buffer = ByteBuffer.allocate(1024);

+ int len = channel.read(buffer);

+ String content = new String(buffer.array(), 0, len);

+ System.out.println(content);

+ }catch (Exception e) {

+

+ }

+

+ }

+}

+```

+

+### Netty 的特点

+

+一个高性能、异步事件驱动的NIO框架。

+

+使用更高效的socket底层,处理了epoll空轮询引起的cpu占用飙升(Netty检测到空轮询的时候,主动重建Selector)

+

+采用decoder/encoder 支持,对TCP粘包/拆包进行自动化处理

+

+可配置IO线程数、TCP参数,TCP 接收和发送缓冲区使用直接内存代替堆内存,通过内存池的方式循环利用 ByteBuf

+

+通过引用计数器及时申请释放不再引用的对象,降低了 GC 频率

+

+使用单线程串行化的方式,高效的 Reactor 线程模型

+

+大量使用了 volitale、使用了 CAS 和原子类、线程安全类的使用、读写锁的使用

+

+### Netty 使用的线程模型

+

+Netty 通过 Reactor 线程模型基于多路复用器接收并处理用户请求,内部实现了两个线程池,boss 线程池和 work 线程池,

+

+其中 boss 线程池的线程负责处理请求的 accept 事件,当接收到 accept 事件的请求时,把对应的 socket 封装到一个,

+

+NioSocketChannel 中,并交给 work线程池,其中 work 线程池负责请求的 read 和 write 事件,由对应的 Handler 处理。

+

+### Netty 的零拷贝实现

+

+- Direct Buffer

+

+ 使用堆外内存进行Socket读写,避免JVM堆内存与内核缓存之间的拷贝

+

+- CompositeByteBuf

+

+ 将多个缓存区"逻辑上"合并为一个缓冲区,避免物理上的数据拷贝

+

+- 文件传输的零拷贝 FileRegion

+

+ 利用操作系统的 `sendfile` 系统调用,直接在文件描述符和套接字之间传输数据,完全跳过用户态

+

+- 缓存区包装 Wrapped Buffers

+

+ 通过包装现有数据(如字节数组、`ByteBuffer`)创建 `ByteBuf`,避免数据贝,`Unpooled.wrappedBuffer(...)` 方法直接引用原始数据,而非复制

+

+- 延迟缓冲区拷贝 Lazy Copy

+

+ 在某些场景下(如缓冲区切片 `slice()`),仅记录原始缓冲区的引用和偏移量,不立即拷贝数据,直到必要时才执行拷贝。

\ No newline at end of file

diff --git a/3.Java Lock.md b/3.Java Lock.md

old mode 100755

new mode 100644

index a20ef6a..6d7e655

--- a/3.Java Lock.md

+++ b/3.Java Lock.md

@@ -17,7 +17,7 @@

公平锁:根据线程请求锁的顺序来获取锁

非公平锁:抢占式获取锁

-### 什么是死锁

+### 什么是死锁,什么情况下产生死锁

具备以下4个条件就会产生死锁:

@@ -125,9 +125,26 @@ yield:

### 什么是虚假唤醒?如何避免

-https://blog.csdn.net/LuckyBug007/article/details/70053669

+AB线程执行了wait()方法,C线程执行了notifyAll()方法唤醒了它们,AB线程就都开始执行,但其中只有一个线程能执行成功,另外一个线程会得到错误的结果。

-wait(),notify()源码分析:https://www.jianshu.com/p/f4454164c017

+避免方式是将wait()方法包裹在while(条件)中,进行循环判断

+

+```java

+synchronized (someObject) {

+ while (!condition) {

+ someObject.wait();

+ }

+ // 现在 condition 为 true,执行你的操作

+}

+

+// 错误用法

+synchronized (someObject) {

+ if (!condition) { // 仅判断一次

+ lock.wait(); // 若此处发生虚假唤醒,线程会直接执行下面的逻辑

+ }

+ // 执行需要条件满足的操作(可能因条件未满足而出错)

+}

+```

### Synchronized原理

@@ -138,7 +155,8 @@ Synchronized可以修饰普通方法、同步方法块、静态方法;

同步方法块锁是Synchonized配置的对象;

用的锁是存在对象头里的,根据mark word的锁状态来判断锁,如果锁只被同一个线程持有使用的是偏向锁,不同线程互相交替持有锁使用轻量级锁,多线程竞争使用重量级锁。锁会按偏向锁->轻量级锁->重量级锁 升级,称为锁膨胀

- https://github.com/farmerjohngit/myblog/issues/12

+

+> 扩展:https://github.com/farmerjohngit/myblog/issues/12

### synchronized和Lock的区别

@@ -146,7 +164,7 @@ Synchronized可以修饰普通方法、同步方法块、静态方法;

2. synchronized 无法显式的判断是否获取锁的状态,Lock可以判断是否获取到锁

3. synchronized 会自动释放锁,Lock需要在finally中手工释放锁

4. synchronized 不同线程获取锁只有一个线程能获取成功,其他线程会一直阻塞直到获取锁,Lock有阻塞锁,也有非阻塞锁,阻塞锁还有尝试设置,功能更强

-5. synchronized 可重入,不可中断,非公平,Lock锁可重入,可判断,有公平锁,非公平锁

+5. synchronized 可重入,不可中断,非公平,Lock锁可重入,可中断,有公平锁,非公平锁

6. Lock锁适合大量同步代码的同步问题,synchronized锁适合代码少量的同步问题

### synchronized 可重入是怎么实现的

@@ -157,7 +175,7 @@ Synchronized可以修饰普通方法、同步方法块、静态方法;

### ReentrantLock可重入性怎么实现的?

-由于ReentrantLock是通过AQS来实现的,其使用了AQS的state状态值来表示线程获取该锁的可重入次数,默认情况下state为0表示当前锁没有被任何线程持有,当一个线程获取该锁时会尝试使用CAS设置state值为1,如果CAS设置成功则当前线程获取了该锁,然后记录该锁的持有者为当前线程,在该线程没有释放锁的情况下第二次获取该锁后,状态值被设置2,这就是可以重入次数,在释放锁的时候,需要通过CAS将状态值减1,直到状态值为0,表示当前线程释放该锁

+由于ReentrantLock是通过AQS来实现的,其使用了AQS的state状态值来表示线程获取该锁的可重入次数,默认情况下state为0表示当前锁没有被任何线程持有,当一个线程获取该锁时会尝试使用**CAS设置state值为1**,如果CAS设置成功则当前线程获取了该锁,然后**记录该锁的持有者为当前线程**,在该线程没有释放锁的情况下第二次获取该锁后,**状态值被设置2**,这就是可以重入次数,在释放锁的时候,需要通过CAS将状态值减1,直到状态值为0,表示当前线程释放该锁

### 非公平锁和公平锁在ReetrantLock里的实现过程是怎样的

@@ -178,15 +196,15 @@ Synchronized可以修饰普通方法、同步方法块、静态方法;

### AbstractQueuedSynchronizer的作用

-抽象同步队列简称AQS,是实现同步器的基础组件,并发包中的锁都是基于其实现的,关键是先进先出的队列,state状态,并且定义了 ConditionObject ,拥有两种线程模式,独占模式和共享模式

+抽象同步队列简称AQS,是实现同步器的基础组件,并发包中的锁都是基于其实现的,关键是**先进先出的队列,state状态**,并且定义了 ConditionObject ,拥有两种线程模式,**独占模式和共享模式**

- AQS核心思想

如果被请求的共享资源空闲,则将当前请求资源的线程设置为有效的工作线程,并且将共享资源设置为锁定状态。如果被请求的共享资源被占用,那么就需要一套线程阻塞等待以及被唤醒时锁分配的机制,这个机制使用CLH队列实现的,即将暂时获取不到锁的线程加入到队列中

-> CLH(Craig,Landin,and Hagersten)队列是一个虚拟的双向队列(虚拟的双向队列即不存在队列实例,仅存在结点之间的关联关系)。AQS是将每条请求共享资源的线程封装成一个CLH锁队列的一个结点(Node)来实现锁的分配, 并保持了上下节点,当前请求资源的线程

+> CLH(Craig,Landin,and Hagersten)(3个人名)队列是一个虚拟的双向队列(虚拟的双向队列即不存在队列实例,仅存在结点之间的关联关系)。AQS是将每条请求共享资源的线程封装成一个CLH锁队列的一个结点(Node)来实现锁的分配, 并保持了上下节点,当前请求资源的线程

-AQS原理图

+

@@ -197,3 +215,11 @@ StampedLock 提供了三种模式的读写控制,当调用获取锁的系列

悲观读锁readLock: 共享锁,在没有线程独占获取写锁的情况下,多个线程可以同时获取该锁,如果已经有其他线程持有写锁,则其他线程请求读锁会被阻塞

乐观读锁tryOptimisticRead: 在操作数据前并没有通过CAS设置锁的状态,仅通过位运算测试

+### CAS 实现的锁和synchronized 锁的性能差异

+

+| 维度 | CAS(乐观锁) | synchronized(悲观锁,可升级) |

+| ------------ | ------------------------------------ | -------------------------------------------- |

+| **竞争低时** | 无锁,自旋少,性能最优 | 偏向锁 / 轻量级锁,开销接近但略高 |

+| **竞争高时** | 自旋浪费 CPU,性能急剧下降 | 重量级锁阻塞线程,避免 CPU 空转,性能更稳定 |

+| **资源开销** | 自旋消耗 CPU,无上下文切换 | 高竞争时上下文切换开销大,但无自旋浪费 |

+| **适用场景** | 简单操作、低冲突(如原子类、计数器) | 复杂逻辑、高冲突(如多步更新、共享资源访问) |

diff --git a/4.JVM.md b/4.JVM.md

old mode 100755

new mode 100644

index 51baaa0..70ee478

--- a/4.JVM.md

+++ b/4.JVM.md

@@ -6,18 +6,24 @@

### JVM运行时内存区域划分

-image-20190922235827314

+image-20190922235827314

-线程独享区域:程序计数器,本地方法栈,虚拟机栈

-线程共享区域:元空间(<=1.7方法区), 堆 +线程独享区域:程序计数器,本地方法栈,虚拟机栈 + +线程共享区域:元空间(<=1.7方法区), 堆 程序计数器:线程私有,是一块较小的内存空间,可以看做是当前线程执行的字节码指示器,也是唯一的没有定义OOM的区块 -本地方法栈: 用于执行Native 方法时使用 + +本地方法栈: 用于执行Native 方法时使用 虚拟机栈:用于存储局部变量,操作数栈,动态链接,方法出口等信息 + 元空间:存储已被虚拟机加载的类元信息,常量,静态变量,即时编译器编译后的代码等数据依旧存储在方法区中,方法区位于堆中 + 堆:存储对象实例 -示例: + + +**元空间OOM示例:** ```java /** @@ -47,21 +53,9 @@ public class JavaMetaSpaceOOM { } ``` - - -### OOM,及SOE的示例、原因,排查方法 +**虚拟机栈OOM** ```java -//OOM -Xmx20m -Xms20m -XX:+HeapDumpOnOutOfMemoryError -public class OOMTest { - public static void main(String[] args) { - List objList = new ArrayList();

- while(true) {

- objList.add(new Object());

- }

- }

-}

-

//SOE栈异常 -Xss125k

public class SOETest() {

static int count = 0;

@@ -80,9 +74,55 @@ public class SOETest() {

}

```

+**堆OOM**

+

+```java

+//OOM -Xmx20m -Xms20m -XX:+HeapDumpOnOutOfMemoryError

+public class OOMTest {

+ public static void main(String[] args) {

+ List objList = new ArrayList();

+ while(true) {

+ objList.add(new Object());

+ }

+ }

+}

+```

+